一、 什么是 Open Edge?

Open Edge 是腾讯云 EdgeOne 为广大开发者打造的技术开放共创平台。

我们将遍布世界各地的边缘节点能力进一步开放,您可以在这里与我们一起探索和构建新一代的 Serverless 应用,期待您加入 Open Edge, 用技术改变世界!

加入 Open Edge 您将享受如下权益:

● 0 费用开通。

● 目前已开放 AI 网关给开发者申请免费试用,AI 网关可实现对大语言模型(LLM )的访问进行管控,已支持 Open AI、Minimax、Moonshot AI 、Gemini AI 、腾讯混元、百度千帆、阿里通义千问和字节豆包等大模型服务商。

二、 AI 网关介绍

1. 功能简介

腾讯云 EdgeOne AI 网关实现了对大语言模型( LLM)服务商访问的安全性、可见性和请求行为控制管理。

目前已支持配置缓存等能力,正开发中的能力:速率限制、请求重试、LLM 模型回退和虚拟秘钥等,能力的组合使用可有效保证访问 LLM 服务商的安全性和稳定性,同时可降低访问成本。

📢 注意:目前为 Beta 版本,我们不建议您用于生产业务环境,如果您想尝试用于您生产业务,请您充分考虑业务风险后,再谨慎使用。

2. 适用场景

● 企业办公:适用于企业管理者通过在员工和 LLM 服务商的访问中间搭建 AI 网关,管控员工对 LLM 服务商的安全访问和成本控制。

● 个人开发:适用于AIGC 个人开发者通过在消费者用户和 LLM 服务商访问的中间搭建 AI 网关,管控消费者用户的请求行为。

3. 功能优势

● 降低成本:利用缓存技术,针对重复的 Prompt 请求,将直接从缓存中提供响应,无需再次调用 LLM 服务商,有效避免不必要的重复费用,从而显著降低您的运营成本。

● 配置灵活:通过配置请求重试、速率限制、LLM 模型回退等能力可应对各种异常和复杂的场景,确保服务的可用。

● 数据监控:通过数据大盘,您可以获得关于AI网关请求的详尽统计信息。这些数据将帮助您洞察流量模式,优化业务流程,并做出更加精准的业务决策。

● 高安全性:采用虚拟秘钥技术,为您提供了一层额外的安全保障。此机制可确保您 LLM 服务商的访问密钥不会被泄露,从而保护了您的数据安全和商业隐私。

📢 注意:上述能力目前并未全部就绪,如果您对某部分能力很关注,请反馈给产品方。

4. LLM 服务商

已支持 Open AI、Minimax、Moonshot AI 、Gemini AI 、腾讯混元、百度千帆、阿里通义千问和字节豆包。

三、 操作指南

1. 开通 Open Edge

腾讯云控制台 进入到 边缘安全加速平台 EO 在左侧菜单栏,单击 Open Edge,如您之前未申请开通,则需先申请开通使用权限,请点击 立即开通

📢 注意:因当前执行分批限量用户测试,如您当前申请未通过,请耐心等待,感谢您的理解。

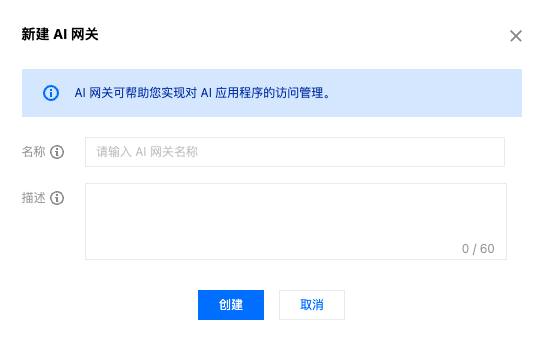

2. 新建 AI 网关

开通成功后,在 AI 网关列表页,单击新建,根据弹窗提示完成名称和描述的输入

● 名称:必填,创建后无法修改,仅包含数字、大小写字母、中划线、下划线字符;名称不允许重复。

● 描述:非必填,最长为60个字符。

3. 配置 AI 网关

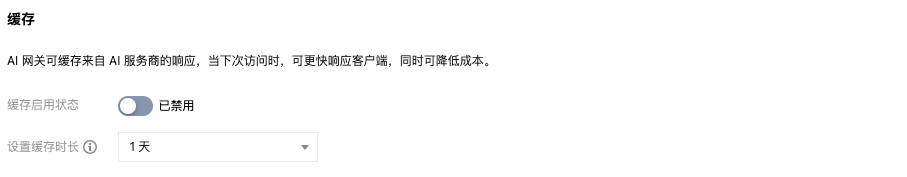

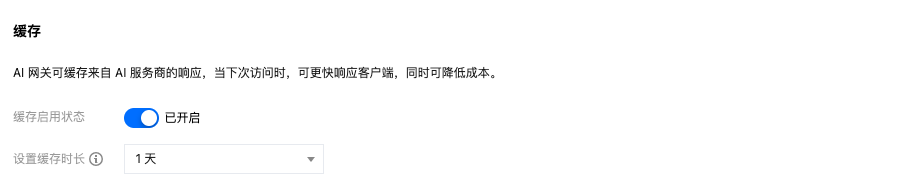

AI 网关新建成功后,在 AI 网关列表页,单击详情或具体的 AI 网关实例 ID 进入到网关的详情页,当前支持配置缓存

● 启用/禁用:打开开关,则启用缓存,针对相同的 Prompt 请求则可直接从网关的缓存响应,无需请求 LLM 服务商;关闭开关,则禁用缓存,每次请求由 LLM 服务商响应。

● 设置缓存时长:支持配置的缓存时长为 2分钟、5分钟、1小时、1天、1周、1月,超过设置时长后,将自动清除缓存。

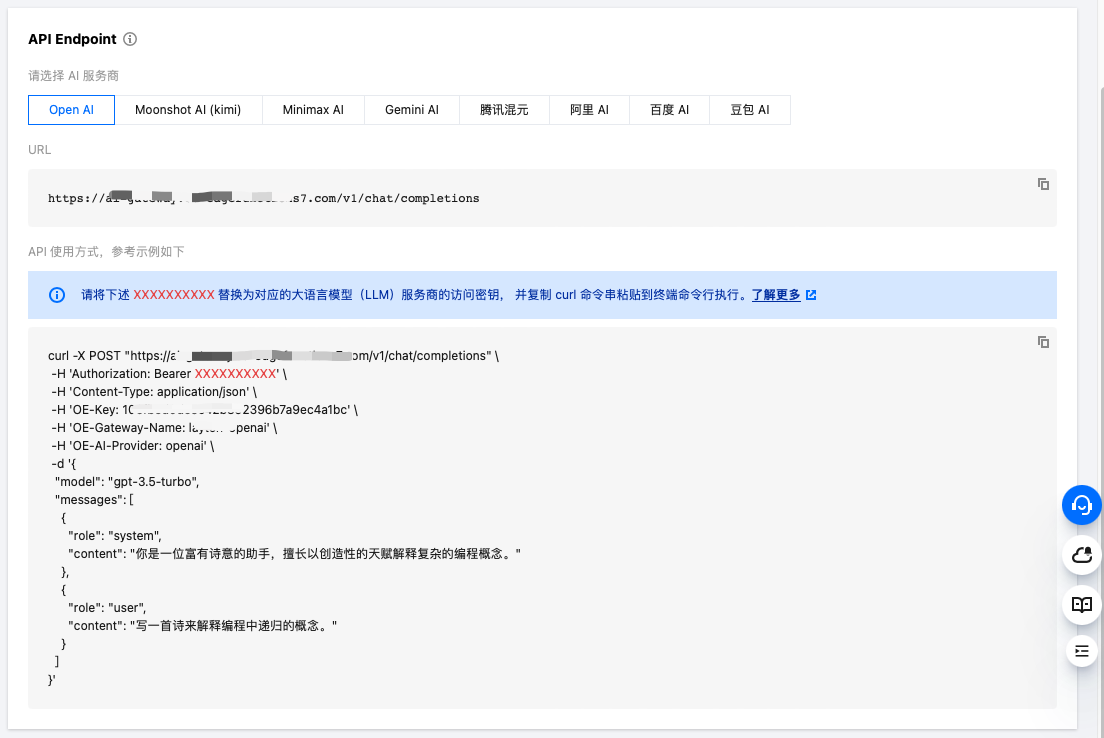

4. API Endpoint

AI 网关后端的对应的 Endpoint 即为大语言模型(LLM)服务商,当前已支持 Open AI、Minimax、Moonshot AI 、Gemini AI 、腾讯混元、百度千帆、阿里通义千问和字节豆包。

您可参照示例将 Bear 的 xxxxxxxxxxxxxxxxxxxxxxxx 替换为服务商的访问秘钥即可,如:Open AI 的 Endpoint

四、案例演示

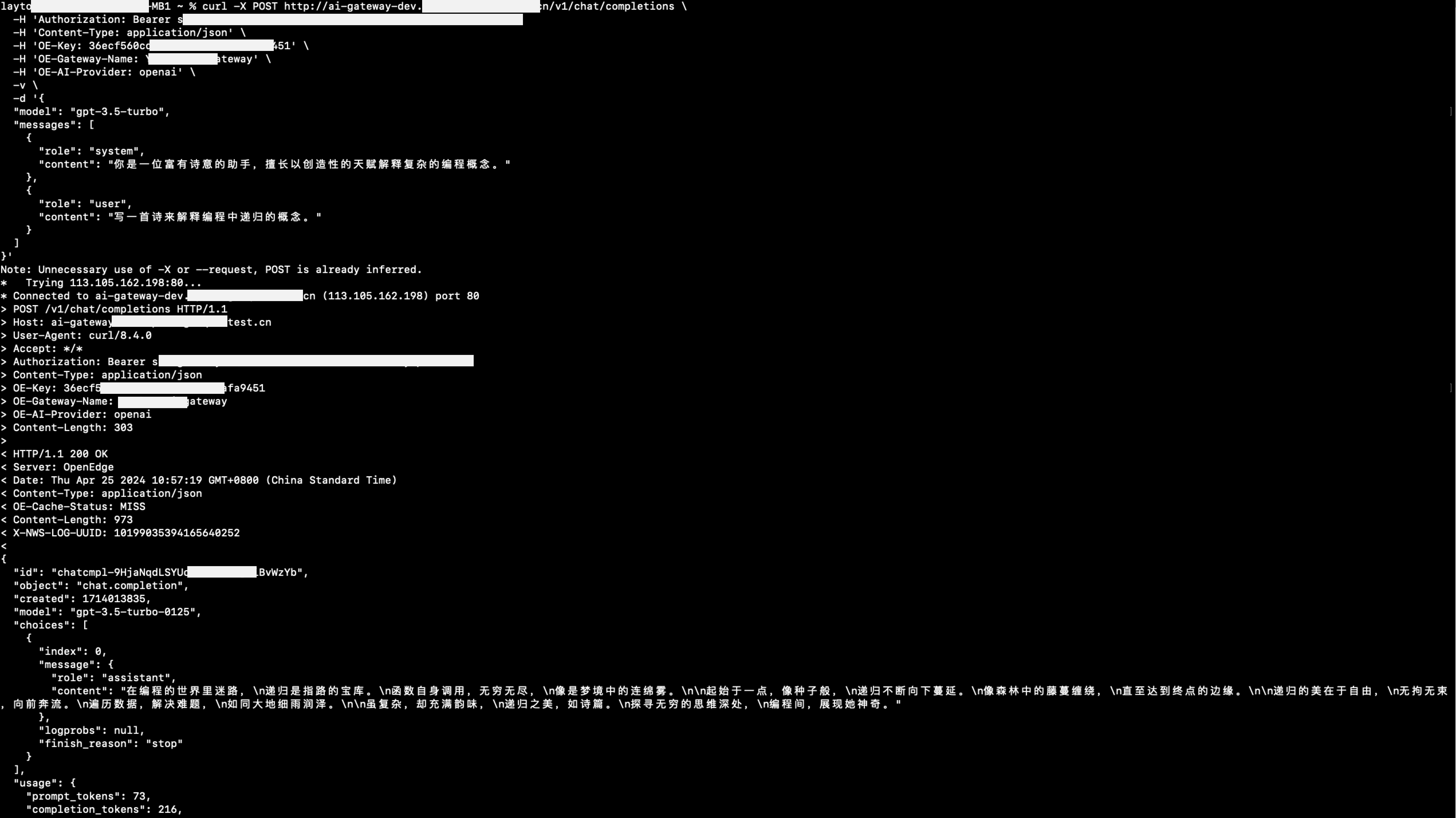

通过 AI 网关访问 Open AI

操作场景:AI 网关禁用缓存,通过 AI 网关访问 Open AI

AI 网关启用缓存,再次访问

响应头 OE-Cache-Status 返回为 HIT 则说明已命中缓存。

通过 AI 网关访问其他 LLM 服务商同理可参考上述操作。

五、常见 FAQ

1. AI 网关是否收费?

AI 网关当前为免费能力,您可放心使用。

2. 如何快速创建并配置 AI 网关?

请参见操作指南。

3. AI 网关是否可支持更多LLM 服务商?

如当前 LLM 服务商不满足您的诉求,您可反馈给产品方进行评估。