计算机视觉研究院专栏

作者:Edison_G

最近我们“计算机视觉研究院”主要推送了目标检测干货及Yolo系列的高质量文章及实践,今天给大家总结一下!

目标检测是现在最热门的研究课题,也一直是工业界重点研究的对象,最近几年内,也出现了各种各样的检测框架,所属于YOLO系列是最经典也是目前被大家认可使用的检测框架。不论是PyTorch,还是Tensorflow,又或者是Keras和Caffe,可以说是全平台通用。

近期我们“计算机视觉研究院”也发布了较多与其紧密相关的干货及实践内容,现在我们一起回顾,有兴趣可以从历史发布中会看!

实用目标检测器 | 性能超YoloV5,推理耗时不变(附github源码)

- 论文地址:https://arxiv.org/pdf/2104.10419.pdf

- 源代码:https://github.com/PaddlePaddle/PaddleDetection

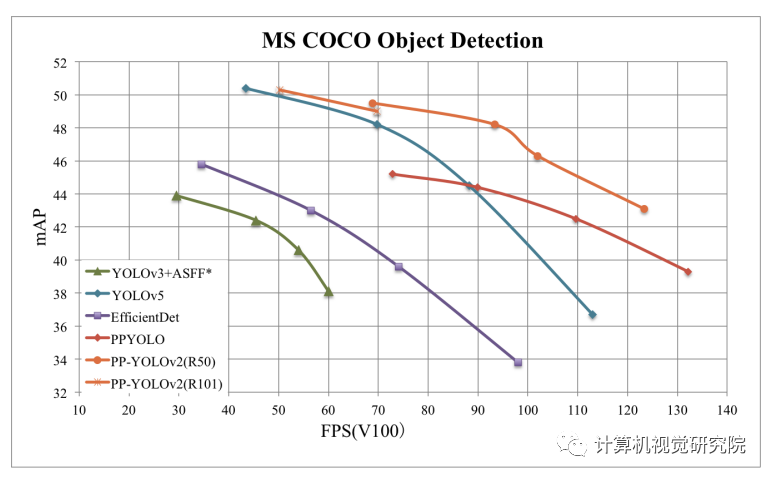

对PP-YOLO的一次升级,从PP-YOLO出发,通过增量消融方式逐步添加有助于性能提升且不增加推理耗时的措施,取得了更佳的性能(49.5%mAP)-速度(69FPS)均衡,并优于YOLOv4与YOLOv5。

百度研究者对现有改进措施进行了分析并通过增强消融研究评估了其对最终模型的影响,此外,那些不起作用的也进行了讨论。通过组合多种有效改进,将PP-YOLO在COCO2017 test-dev数据上的性能从45.9%mAP提升到了49.5%mAP,并将所得到的模型称之为PP-YOLOv2。在推理速度方面,PP-YOLOv2可以达到68.9FPS(输入尺寸为640*640);采用Paddle推理引擎+TensorRT+FP16+bs1,可以进一步将PP-YOLOv2的推理速度提升到106.5FPS。优秀的性能完全超越了同等参数量的YOLOv4-CSP、YOLOv5l等模型。除此之外,采用ResNet101为主干网络的PP-YOLOv2可以在COCO2017 test-dev数据集上取得50.3%mAP。

Yolo系列的巅峰之作:更确的目标检测框架(附源代码)

- 论文地址:https://arxiv.org/pdf/2107.08430.pdf

- 源代码:https://github.com/Megvii-BaseDetection/YOLOX

- yolov5源码:https://github.com/ultralytics/yolov5

YOLOX在YOLO系列的基础上做了许多有意思的工作,其主要贡献在于:在YOLOV3的基础上,引入了“Decoupled Head”,“Data Augmentation”,“Anchor Free” 和“SimOTA样本匹配”的方法,构建了一种anchor-free的端到端目标检测框架,并且达到了顶级的检测水平。

CVPR21目标检测新框架:不再是YOLO,而是只需要一层特征(干货满满,建议收藏)

- 论文地址:https://arxiv.org/pdf/2103.09460.pdf

YoloF的模型比之前的模型复杂了不少,可以通过改变模型结构的大小来权衡速度与精度。YoloV3的先验检测系统将分类器或定位器重新用于执行检测任务。他们将模型应用于图像的多个位置和尺度。此外,相对于其它目标检测方法,YoloV3将一个单神经网络应用于整张图像,该网络将图像划分为不同的区域,因而预测每一块区域的边界框和概率,这些边界框会通过预测的概率加权。模型相比于基于分类器的系统有一些优势。它在测试时会查看整个图像,所以它的预测利用了图像中的全局信息。与需要数千张单一目标图像的R-CNN不同,它通过单一网络评估进行预测。这令YoloV3非常快,一般它比R-CNN快1000倍、比Fast R-CNN快100倍。

YOLOF框架主要对单阶段目标检测中的FPN进行了重思考并指出FPN的成功之处在于它对目标检测优化问题的分而治之解决思路而非多尺度特征融合。从优化的角度出发,作者引入了另一种方式替换复杂的特征金字塔来解决该优化问题:从而可以仅仅采用一级特征进行检测。

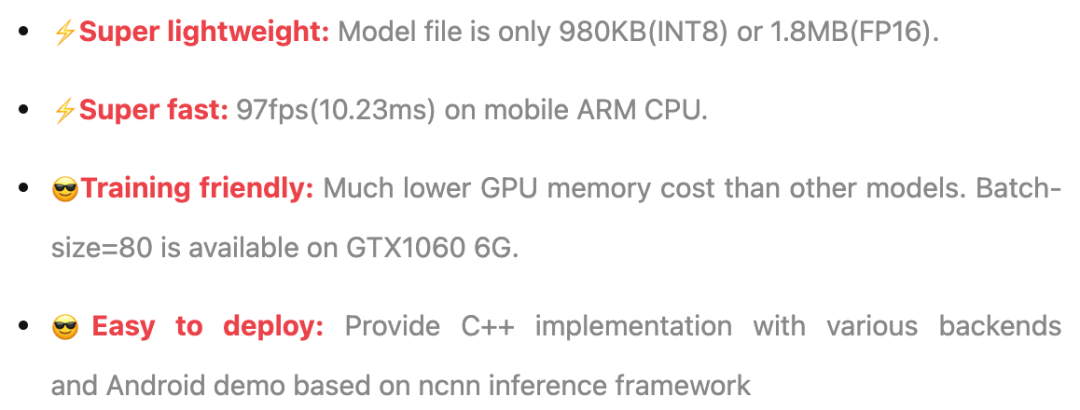

不再只有Yolo,现在轻量级检测网络层出不穷(框架解析及部署实践)

- 开源代码:https://github.com/RangiLyu/nanodet

NanoDet总体而言没有特别多的创新点,是一个纯工程化的项目,主要的工作就是将目前学术界的一些优秀论文,落地到移动端的轻量级模型上。最后通过这些论文的组合,得到了一个兼顾精度、速度和体积的检测模型。

Super fast and lightweight anchor-free object detection model. Real-time on mobile devices.

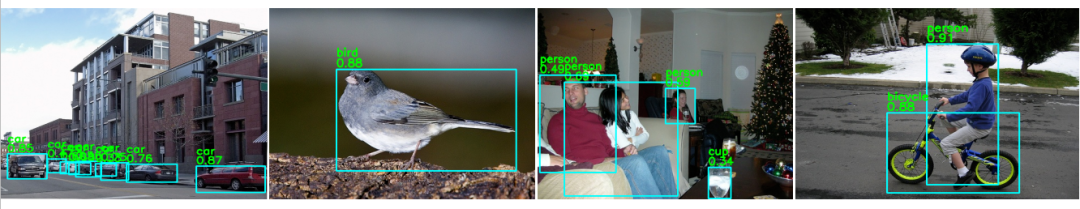

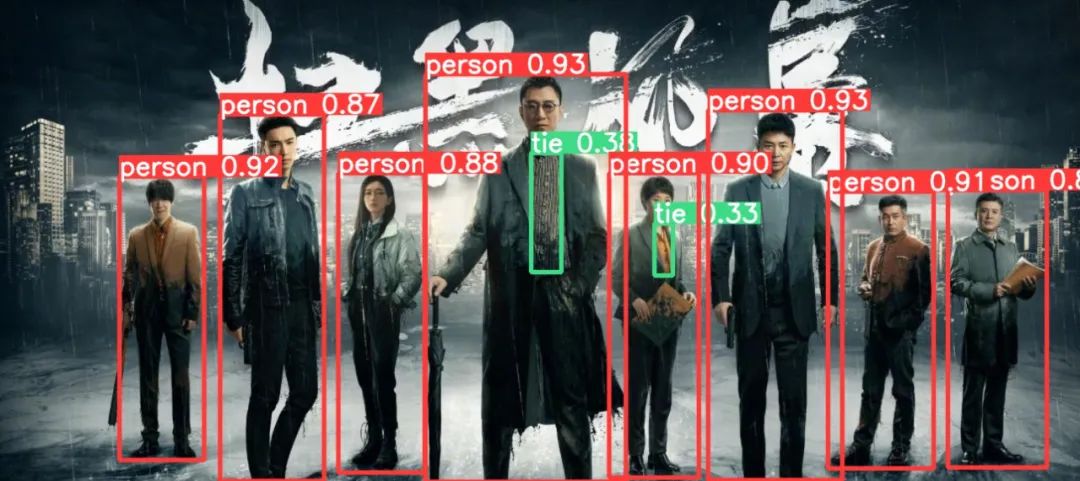

Yolo轻量级网络,超轻算法在各硬件可实现工业级检测效果(附源代码)

- 开源代码:Yolo-Fastest开源代码:https://github.com/dog-qiuqiu/Yolo-Fastest

Yolo-Fastest注重的就是单核的实时推理性能,在满足实时的条件下的低CPU占用,不单单只是能在手机移动端达到实时,还要在RK3399,树莓派4以及多种Cortex-A53低成本低功耗设备上满足一定实时性,毕竟这些嵌入式的设备相比与移动端手机要弱很多,但是使用更加广泛,成本更加低廉。

总结下新框架的特性:

- 简单、快速、紧凑、易于移植

- 资源占用少,单核性能优异,功耗更低

- 更快更小:以0.3%的精度损失换取30%的推理速度提升,减少25%的参数量

- 训练速度快,算力要求低,训练只需要3GB显存,gtx1660ti训练COCO 1 epoch仅需4分钟

Pad-YoloV5:在便携终端上实时检测不再是难题

目标检测是现在最热门的研究课题,现在的框架越来越多,但是技术的新颖性到了瓶颈,目前开始流行Transformer机制,而且在目标检测领域也能获得较大的提升,也是目前研究的一个热点。

目前最流行的还是Yolo系列框架,最近我们“计算机视觉研究院”也分享了很对目标检测干活及实践,都是Yolo-Base框架。

© THE END

转载请联系本公众号获得授权