杨净 发自 凹非寺 量子位 | 公众号 QbitAI

资深开发大佬,终于忍不住自己出来创业了。

Georgi Gerganov,今年三月曾开源了llama.cpp项目,GitHub上已破三万星标,要知道Stable Diffusion也不过8.8k。

这个项目能让开发者在没有GPU情况下运行Meta的LLaMA模型,即便是在树莓派、MacBook上运行大模型也通通不在话下~

△在 M2 Max 上以 40 tok/s 的速度运行 7B LLaMA

甚至还成功吸引了小扎的注意:Meta也在运行llama.cpp。

可能由于反响太好,这位大哥决定把背后核心纯C语言框架ggml拿出来创业:原本是几月前的副业项目。

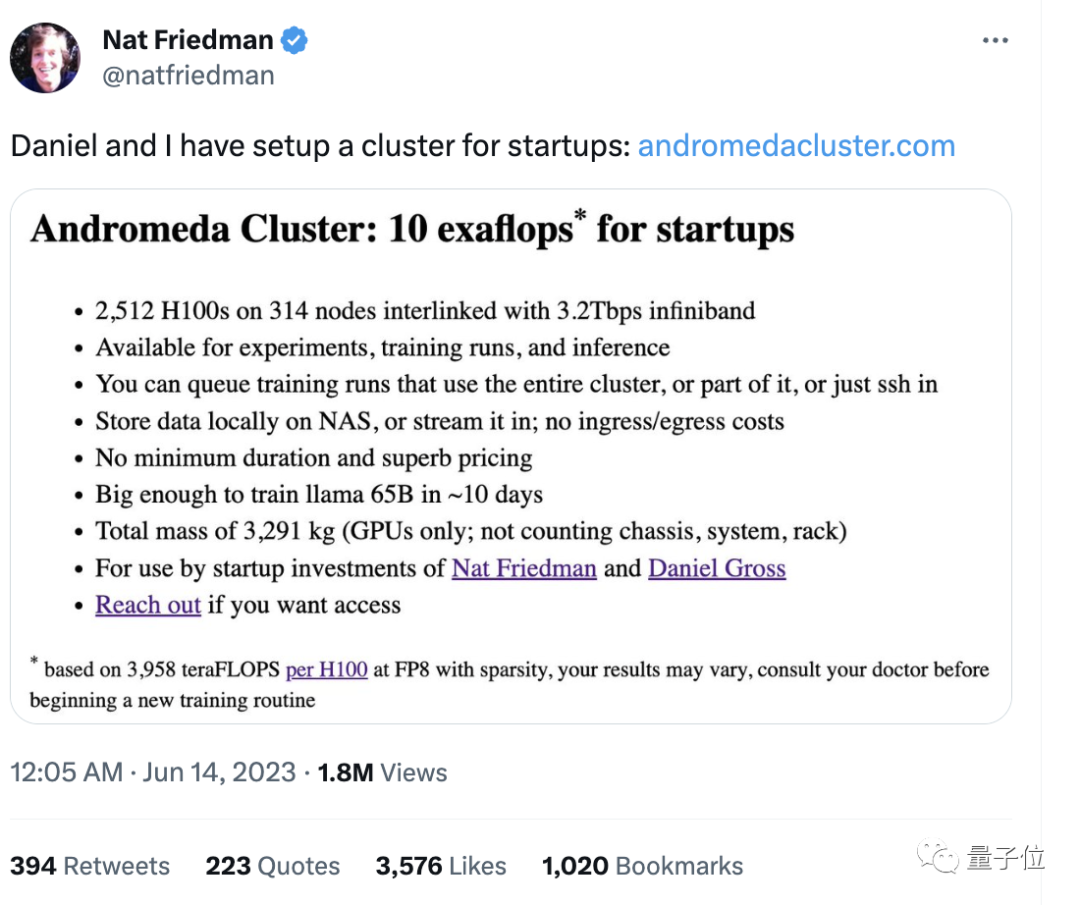

在官宣前这家公司就已经获得来自GitHub前CEONat Friedman、Y Combinator合伙人Daniel Gross的种子前投资。

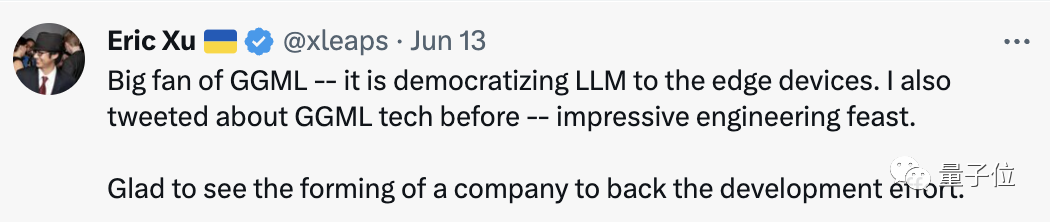

消息一出,众多开发者赶来祝贺。

其中不乏一些坚定的拥护者:ggml正在将大模型普及到边缘设备。

没过多久就有人建议:苹果应该将它收购了。(狗头)

llama.cpp作者创业

ggml,是一个纯C语言编写的张量库,可帮助开发者在消费级硬件上运行大模型,GitHub星标数达到4.4k。

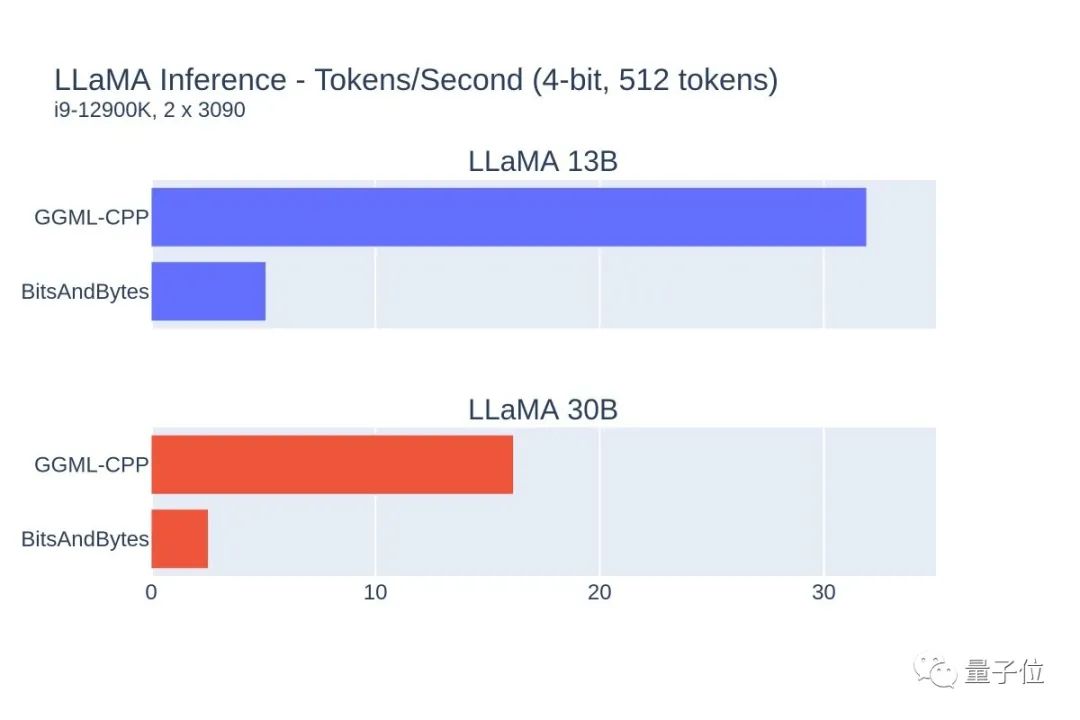

由于加速效果惊人,一下子收获了不少开发者的支持。

By the way,ggml的gg恰好是他名字的缩写。

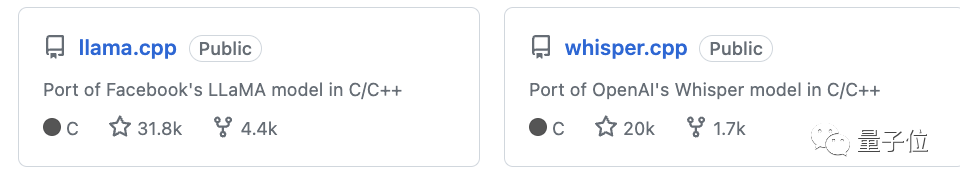

大哥自己的两个上万星标的项目llama.cpp和whisper.cpp都使用了它。

后者是为OpenAI的Whisper自动语音识别模型开发的加速方案,可在Mac、Windows、Linux、iOS、安卓、树莓派以及web上运行。

△使用whisper.cpp在 树莓派上检测短语音命令

不少初创公司,比如主打生活搜索引擎的rewind都使用了这套解决方案。

还有两个项目同时在终端上运行。

△在单个M1Pro上同时运行4个13B LLaMA+Whisper Small实例

根据个人介绍,ggml张量库具有以下这些特点:

支持 16bit 浮点数;支持整数量化(包括 4 位、5 位、8 位);自动微分;内置优化算法(例如 ADAM、L-BFGS);为苹果芯片设置特定优化;在 x86 架构上使用AVX / AVX2 Intrinsic;通过WebAssembly和WASM SIMD提供Web支持;无第三方依赖;运行时零内存分配;支持指导型语言输出……

目前这个库以及相关项目都是免费开源,开发过程也全公开;当然也不排除开发授权给一些商业用途的项目。

用C/C++重写神经网络代码

而这背后的开发大佬Georgi Gerganov也值得说道说道。

他的个人网站十分简单直接,甩出各种开源项目,除此之外别无其他。可以看出,他是C/C++的狂热爱好者,信仰Vim。

此前,他曾用C/C++语言重写神经网络推理代码,这样几乎不依赖于其他库,以此提升效率。至于llama.cpp也是他一晚上Hacking出来的。

除此之外,他还有一些有意思的项目。

比如检查键盘是否可以通过麦克风窃听、猜Hacker News的标题,Wordle克隆版等等。

One More Thing

值得一提的是,背后的这两个投资者也有点意思。

他们还专门给创业者提供算力集群,只需在网站上申请即可。这波是在Next Level上了~