大家好,我是民工哥!

对于我们程序员来说,使用爬虫技术是我们常用的采集数据手段之一,它可以帮助我们自动化地从互联网上获取各种数据,包括文本、图片、音频、视频等。

说起爬虫,它可是个让人又爱又恨的小家伙啊!有时它就像个勤劳的小蜜蜂,在网络的百花园里忙得不亦乐乎,为我们采集那些甜美的数据花朵。但,小蜜蜂有时候也不是那么好伺候的,时不时会遇到些头疼的问题,让人哭笑不得。

网络世界可不是个自由市场,到处都有“守门员”(服务器管理员)。他们为了保护自己的数据不被随意抓取,设置了各种防爬策略,比如限制访问频率、验证码验证、IP封锁等等。

但,我们聪明的爬虫工程师们可不会轻易放弃。他们开始施展各种“魔法”——使用代理IP、模拟用户行为、验证码识别等等,试图绕过这些障碍。

但是,这些“魔法”也不是万能的,有时候反而会弄巧成拙,比如被识别为恶意攻击而遭到更严厉的封锁。

除了“守门员”的阻挠,网络世界还充满了各种“陷阱”。有些网站为了吸引爬虫,故意发布一些虚假信息或者设置一些诱饵链接。

爬虫一不小心就会中招,抓取到一堆垃圾数据或者陷入无限循环。这就像是在森林里迷路的旅人,越走越偏,最后连回家的路都找不到了。

爬虫技术就像是一场充满挑战和乐趣的冒险之旅。虽然会遇到各种困难和问题,但是只要我们保持一颗勇敢和好奇的心,就一定能够找到解决问题的方法,获取到那些宝贵的数据宝藏!

自动化工具

一个浏览器,实现批量数据抓取,非常强大!点击免费试用即可。

点击查看代理IP产品

选择亮数据浏览器

添加新代理:名字可自定义。

点击查看代码集成示例

输入目标网站,和国家。

可以看到,选好语言 Python 模块后,这边自动生成了对应的脚本,在执行前,这里需要安装一下亮数据的第三方 Python 模块。

pip3 install playwright

安装成功后,将案例代码复制到python编辑器中执行。

import asyncio from playwright.async_api import async_playwrightSBR_WS_CDP = 'wss://brd-customer-hl_4565ddce-zone-scraping_browser1-country-cn'

async def run(pw):

print('Connecting to Scraping Browser...')

browser = await pw.chromium.connect_over_cdp(SBR_WS_CDP)

try:

page = await browser.new_page()

print('Connected! Navigating to https://baidu.com...')

await page.goto('https://baidu.com')

# CAPTCHA handling: If you're expecting a CAPTCHA on the target page, use the following code snippet to check the status of Scraping Browser's automatic CAPTCHA solver

# client = await page.context.new_cdp_session(page)

# print('Waiting captcha to solve...')

# solve_res = await client.send('Captcha.waitForSolve', {

# 'detectTimeout': 10000,

# })

# print('Captcha solve status:', solve_res['status'])

print('Navigated! Scraping page content...')

html = await page.content()

print(html)

finally:

await browser.close()async def main():

async with async_playwright() as playwright:

await run(playwright)

if name == 'main':

asyncio.run(main())

数据集服务

这是该平台一个非常棒的功能,如果你不想费时费力的去获取想要的数据,或者说对代码的运行不太专,我建议你不妨试一试它。

访问亮数据官网,点击菜单网络数据-数据集-获取免费样本,即可体验数据集服务了。

也可在之前的代理配置页面直接点击左侧的数据收集器,然后选择定制数据。

下面的选项大家可以按需选择(左:全方位,右:定制化)

开始创建代理端口

开始填写所需的数据,比如这里我要爬取百度的图片,填写如下:

点击下一页之后,会自动去抓取内容

抓取完成

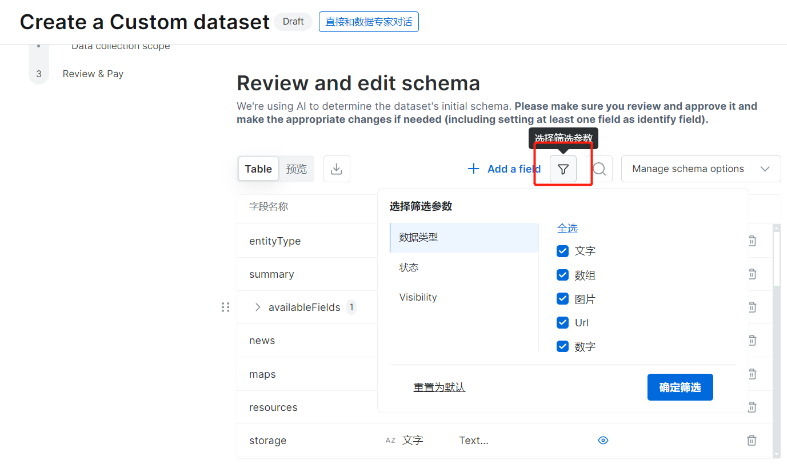

你也可以根据你的需求进行相关的筛选

点击确定筛选

我们可以对抓取到的数据进行下载,内置提供有 JSON 和 CSV 两种数据保存格式。