文 | MLer

979字 | 3分钟阅读

感谢李宏毅老师的分享,他的课程帮助我更好地学习、理解和应用机器学习。李老师的网站:http://speech.ee.ntu.edu.tw/~tlkagk/index.html。这个学习笔记是根据李老师2017年秋季机器学习课程的视频和讲义做的记录和总结。因为这个视频是在Youtube上面,有些朋友可能无法观看,我把它搬运下来放在云盘上面,大家点击阅读原文,就可以直接在手机随时随地观看了。再次,感谢李老师的付出和贡献。

这门课,共有36个视频,每个视频播放的时间不一。我按着视频播放的顺序,观看,聆听和学习,并结合讲义,做学习笔记。我做学习笔记目的有三:

1 帮助自己学习和理解机器学习

2 记录机器学习的重要知识、方法、原理和思想

3 为传播机器学习做点事情

视频10:逻辑回归

一、问题定义

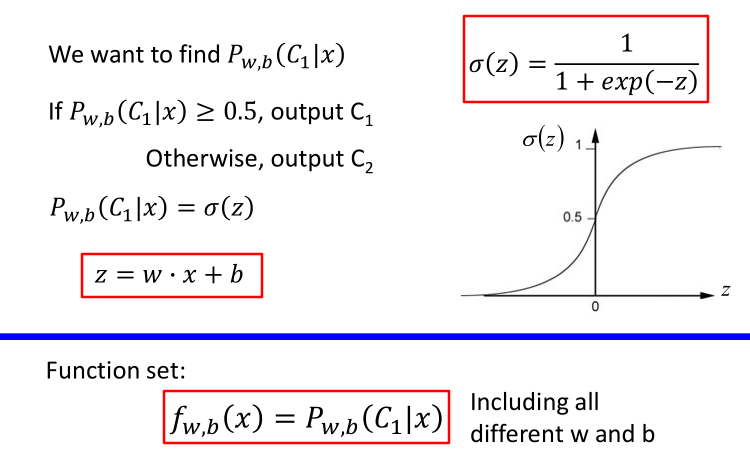

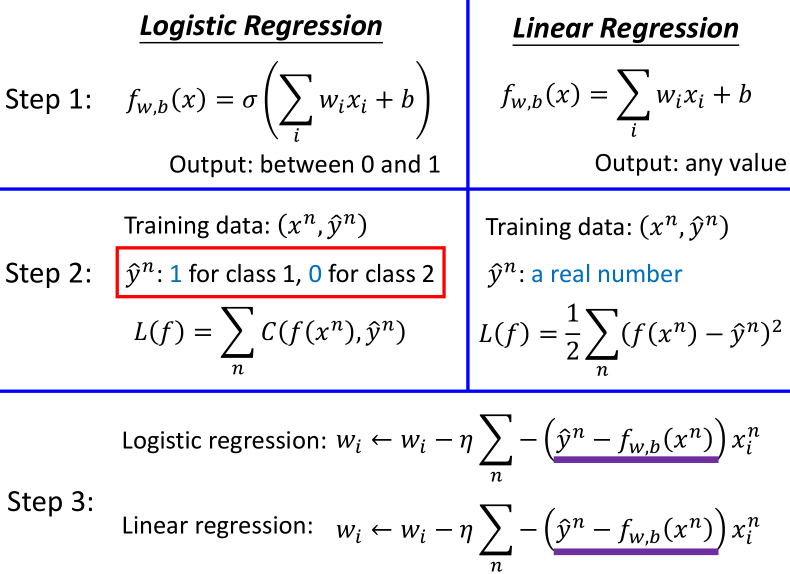

第一步:函数集,逻辑回归算法的表示,如下图:

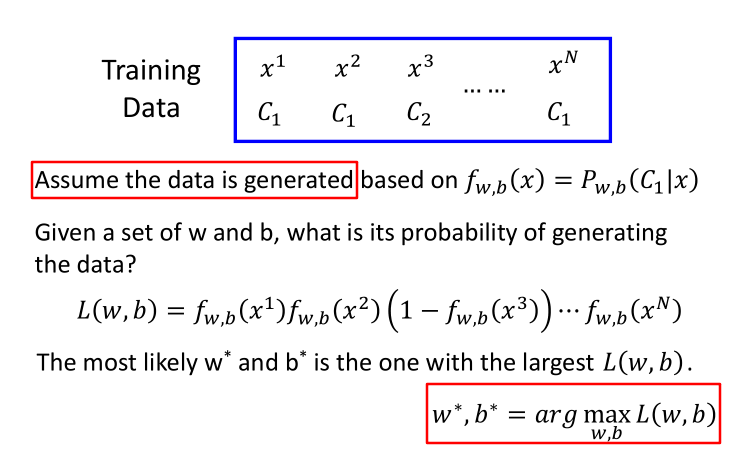

第二步:函数集好坏度量(最大化好,最大化似然概率;最小化坏,最小化损失函数)

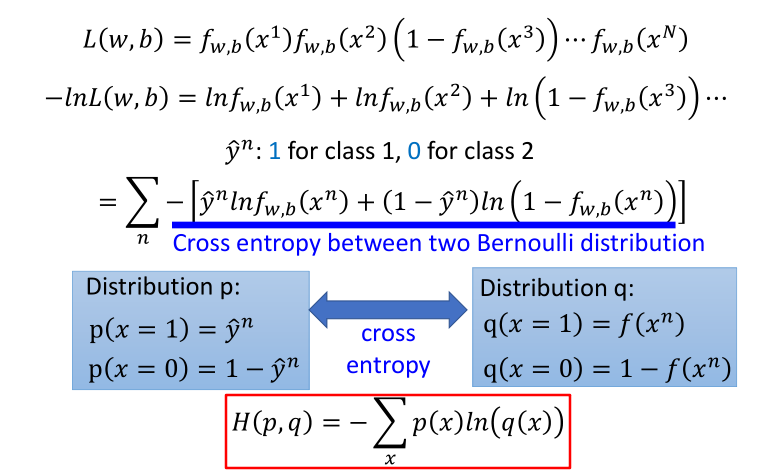

交叉熵:用于度量两个概率有多接近(真实概率与预测概率)

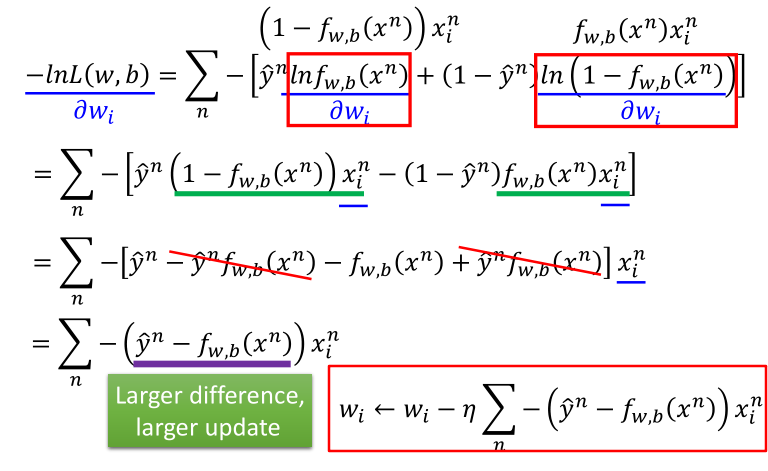

第三步:寻找最佳的函数,获取最佳函数对应的参数

二、逻辑回归与线性回归对比

如下图:

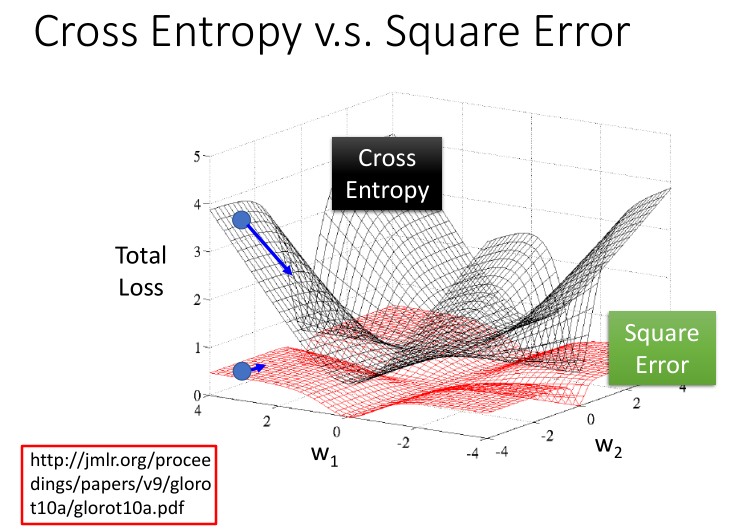

三、逻辑回归的损失函数

逻辑回归损失函数,为什么不用平方误差表示?

这个问题,李老师从数学分析和可视化分析,做了详细地介绍。我们容易发现,若用平方误差这种损失函数,在逻辑回归算法里面,不容易找到最优解。更详细的内容,请点击阅读原文,观看视频。

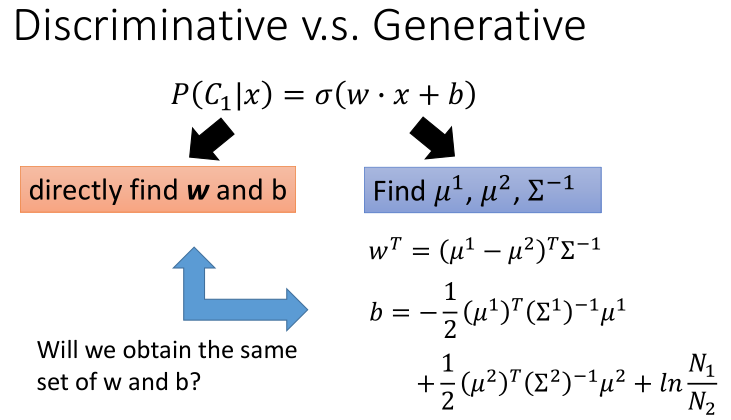

四、判别模型和生成模型

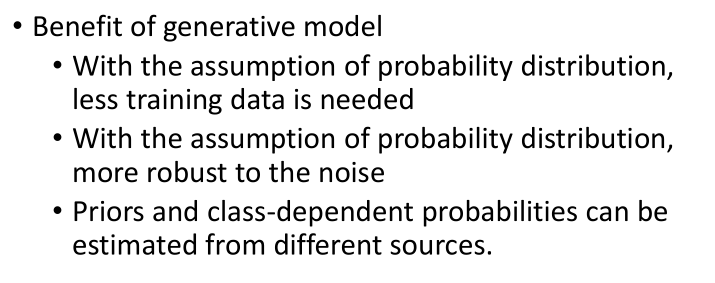

1)判别模型和生成模型对比

2)生成模型的优势

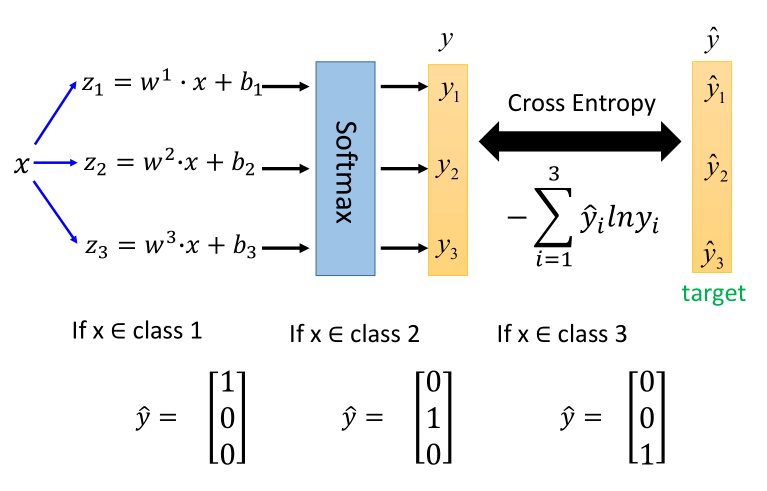

五、多分类问题

问题解决的思路,使用Softmax,如下图:

六、逻辑回归的局限性

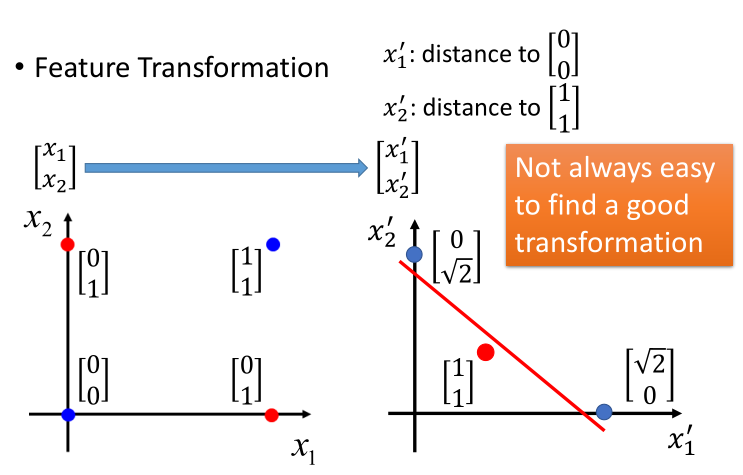

异或逻辑,无法求解。如下图:

解决方案:

1) 特征变换 专家知识

问题:不总是容易找到最好的特征变换

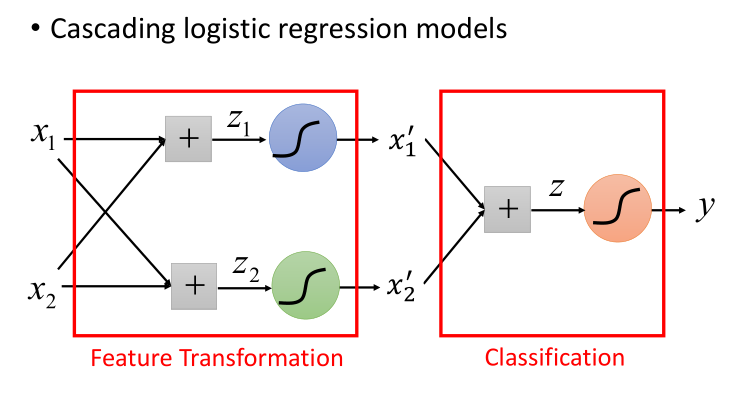

2)逻辑回归多级级联 机器学习知识

由逻辑回顾过渡到神经网络和深度学习。

更纤细的内容,请点击http://47.112.229.252:8082/files/905bcca4-3b1a-4030-85f5-e3cf595cdfb1/ML%20Lecture%205_%20Logistic%20Regression.mp4,观看视频。

思考题:

1 逻辑回归与线性回归有什么区别?

2 逻辑回归的损失函数如何设计和构建?

3 逻辑回归算法的局限性?

4 多分类问题的解决方案?

5 逻辑回归与神经网络的关系?