文章目录

- I . 决策树模型

- II . 决策树模型 示例

- III . 决策树算法列举

- IV . 决策树算法 示例

- V . 决策树算法性能要求

- VI . 决策树模型创建 ( 递归创建决策树 )

- VII . 决策树 树根属性 选择

I . 决策树模型

1 . 决策树 : 决策时基于 “树” 结构 , 这也是模拟人在进行决策时采用的策略 ;

2 . 决策树组成 : 根节点 , 内部节点 , 叶子节点 , 这些节点都是数据的 属性 ( 特征 ) ;

① 根节点 : 最初始判定的属性 , 判定区域是全局的数据集 ;

② 内部节点 : 中间的判定属性 , 判定区域是符合某些特征的子数据集 ;

② 叶子节点 : 决策结果 , 位于决策树的最底层 , 每个叶子节点都是一个决策结果 ;

3 . 决策树模型过程 :

① 训练过程 : 使用训练集数据确定决策时使用的属性 , 确定根节点 , 内部节点 , 叶子节点 的属性划分 , 训练决策树模型 ;

② 预测过程 : 从根节点特征开始 , 根据决策树中的判定序列依次从根节点向下判定 , 直到一个叶子节点 ;

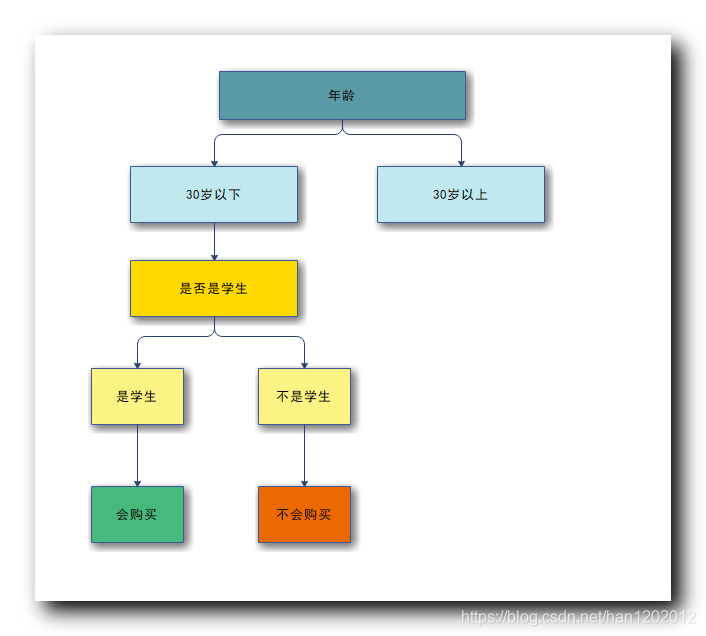

II . 决策树模型 示例

1 . 需求场景 :

① 需求 : 电商网站为用户进行分类 , 目的是确定该用户是否有可能购买某件商品 , 然后为其推送指定商品的广告 ;

② 决策树使用 : 如何对用户进行分类 , 这里就用到了决策树模型 , 将用户分成不同的类别 ;

2 . 数据集 : 决策过程中 , 根据每个节点所处理的数据集的特征 , 将其划分到不同的子节点中进行处理 ; 如数据集中是 100 个用户的信息 ;

3 . 决策树构成 :

① 根节点决策 : 根节点 处理年龄特征 , 小于 30 岁的用户划分到一组 , 大于 30 岁的用户划分到另一组 ;

② 内部节点决策 : 然后在 小于 30 岁的用户中继续判定 , 学生划分成一组 , 非学生划分成一组 ;

③ 叶子节点决策结果 : 学生会买电脑 , 非学生不会买电脑 ;

III . 决策树算法列举

1 . 常用的决策树算法 :

① CLS 算法 : 这是第一个决策树算法 , 1966 年提出 ;

② ID3 算法 : 该算法使决策树称为机器学习主流技术 , 1979 年提出 ;

③ C4.5 算法 : 最常用的决策树算法 ; 1993 年提出 ;

④ 区别 : 上述三个算法五个组件基本一致 , 唯一的区别是确定属性划分时的策略不同 , 即将哪个属性放在树根 , 将哪个属性放在内部节点上 , 内部节点的属性所在层级如何设置 ;

2 . 属性划分策略 :

① ID3 算法属性划分策略 : ID3 使用信息增益策略 ;

② C4.5 算法属性划分策略 : C4.5 使用的是增益率策略 ;

3 . CART 算法 : 既可以用于分类任务 ( 结果是离散值 ) , 也可以用于回归任务 ( 结果是连续值 ) ;

4 . FR 算法 : 随机森林算法 ; 使用了数据挖掘 , 机器学习中的集成思想 ; 有很多差的分类器 , 准确率都很低 , 但是多个分类器集成起来 , 准确率就很高 ;

IV . 决策树算法 示例

1 . 需求场景 :

① 需求 : 电商网站为用户进行分类 , 目的是确定该用户是否有可能购买某件商品 , 然后为其推送指定商品的广告 ;

② 决策树使用 : 如何对用户进行分类 , 这里就用到了决策树模型 , 将用户分成不同的类别 , 买的一类 , 和不买的一类 ;

2 . 模拟数据集 : 给出一组数据集 , 后面的所有计算都是基于该数据集进行的 ;

需求 : 根据 年龄 , 收入水平 , 是否是学生 , 信用等级 , 预测该用户是否会购买商品 ;

年龄 | 收入水平 | 是否是学生 | 信用等级 | 是否购买商品 |

|---|---|---|---|---|

小于 30 岁 | 高收入 | 不是 | 一般 | 不会 |

小于 30 岁 | 高收入 | 不是 | 很好 | 不会 |

31 ~ 39 岁 | 高收入 | 不是 | 一般 | 会 |

40 岁以上 | 中等收入 | 不是 | 一般 | 会 |

40 岁以上 | 低收入 | 是 | 一般 | 会 |

40 岁以上 | 低收入 | 是 | 很好 | 不会 |

31 ~ 40 岁 | 低收入 | 不是 | 很好 | 会 |

小于 30 岁 | 中等收入 | 不是 | 一般 | 不会 |

小于 30 岁 | 低收入 | 是 | 一般 | 会 |

40 岁以上 | 中等收入 | 是 | 一般 | 会 |

小于 30 岁 | 中等收入 | 是 | 很好 | 会 |

31 ~ 39 岁 | 中等收入 | 不是 | 很好 | 会 |

31 ~ 39 岁 | 高收入 | 是 | 一般 | 会 |

40 岁以上 | 中等收入 | 不是 | 很好 | 不会 |

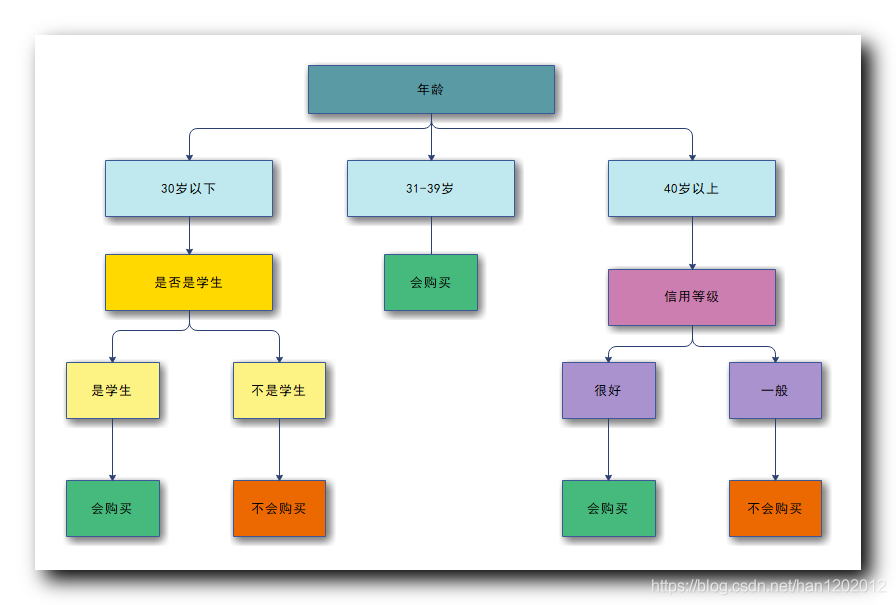

3 . 决策树模型 :

建立模型 : 将上述数据集的 属性 ( 特征 ) 转换为树状的模型 ;

确定树根 : 首先要确定哪个属性作为树根 , 这个选择是有一定要求的 , 不能随意指定一个任意的特征作为树根 ;

4 . 决策树 属性划分 :

属性划分策略 : 根据一定的策略 , 确定哪个属性作为树根 , 然后每个子树 , 在确定剩余的哪个属性作为子树的树根 , 这是递归问题 ;

属性划分的算法性质 : 递归算法 ;

如何决定树根属性 : 确定总树的树根 , 及每个子树的树根 , 要求根据数据的 属性 ( 特征 ) 进行的决策次数尽量能做到最少 ;

V . 决策树算法性能要求

1 . 决策树的高度 :

① 决策树最大高度 : 决策属性的个数 ; ( 每个属性都要决策一次 , 才能预测出结果 )

② 决策时最小高度 : 1 ; ( 只需要决策一次 , 就可以预测出结果 )

2 . 决策树性能 : 决策树越矮越好 , 即预测某特征 , 进行的决策次数越少越好 ;

3 . 树根属性 : 越重要的属性 , 其越能将数据最大可能拆分开 , 将重要的属性放在树根 ;

VI . 决策树模型创建 ( 递归创建决策树 )

1 . 决策树模型创建 : 决策树模型创建的核心就是选择合适的树根 , 将重要的属性放在树根 , 然后子树中 , 继续选择子树中重要的属性放在子树的树根 , 依次递归 , 最终得到决策结果 ( 叶子节点 ) ;

2 . 决策树创建算法 ( 递归 ) : 使用递归算法 , 递归算法分为递归操作 和 递归停止条件 ;

3 . 递归操作 : 每个步骤先选择属性 , 选择好属性后 , 根据 总树 ( 子树 ) 的树根属性划分训练集 ;

① 选择属性 : 递归由上到下决定每一个节点的属性 , 依次递归构造决策树 ;

② 数据集划分 : 开始决策时 , 所有的数据都在树根 , 由树根属性来划分数据集 ;

③ 属性离散化 : 如果属性的值是连续值 , 需要将连续属性值离散化 ; 如 : 100 分满分 , 将 60 分以下分为不及格数据 , 60 分以上分为及格数据 ;

4 . 递归停止的条件 :

① 子树分类完成 : 节点上的子数据集都属于同一个类别 , 该节点就不再向下划分 , 称为叶子节点 ;

② 属性 ( 节点 ) 全部分配完毕 : 所有的属性都已经分配完毕 , 决策树的高度等于属性个数 ;

③ 所有样本分类完毕 : 所有的样本数据集都分类完成 ;

VII . 决策树 树根属性 选择

1 . 属性选择方法 : 树根属性选择的方法很多 , 这里介绍一种常用的方法 , 信息增益 ;

2 . 信息增益 : 信息增益 效果越大 , 其作为树根属性 , 划分的数据集分类效果越明显 ;

3 . 信息 和 熵 : 涉及 信息论 的知识点 , 建议有空就去 B站 刷一下信息论课程 ;

① 信息 与 熵 的关系 : 信息 会 消除 熵 , 熵 代表了不确定性 , 信息用来消除不确定性 ;

② 信息增益 : 信息增益大的属性 , 能最大消除熵的不确定性 ;

4 . 决策树中的信息增益 : 属性的 信息增益 越大 , 就越能将分类效果达到最大 ;

如 : 想要从用户数据集中找到是否能买奢侈品的用户 , 先把高收入群体划分出来 , 将低收入者从数据集中去除 , 这个收入水平的属性 ( 特征 ) , 信息增益就很大 ;