文章:OmniColor: A Global Camera Pose Optimization Approach of LiDAR-360Camera Fusion for Colorizing Point Clouds

作者:Bonan Liu1, Guoyang Zhao1, Jianhao Jiao, Guang Cai, Chengyang Li,Handi Yin, Yuyang Wang, Ming Liu1 and Pan Hui

编辑:点云PCL

欢迎各位加入知识星球,获取PDF论文,欢迎转发朋友圈。文章仅做学术分享,如有侵权联系删文。

公众号致力于点云处理,SLAM,三维视觉,高精地图等领域相关内容的干货分享,欢迎各位加入,有兴趣的可联系dianyunpcl@163.com。文章未申请原创,侵权或转载联系微信cloudpoint9527。

摘要

着色点云作为简单高效的3D表示,在各个领域都具有许多优势,其中包括机器人导航和场景重建,这种表示现在常用于依赖相机和LiDAR的3D重建任务中。然许多现有框架中对这两种类型传感器的数据进行融合的效果很差,导致了不理想的映射结果,主要是由于相机姿态不准确。本文提出了OmniColor,一种使用独立360度相机对点云进行上色的新颖高效算法。给定一个基于LiDAR的点云和一系列带有初始粗略相机姿态的全景图像,我们的目标是共同优化所有帧的姿态,以将图像映射到几何重建上。我们的流程以一种即插即用的方式工作,不需要任何特征提取或匹配过程。相反,我们通过直接最大化LiDAR地图的光度一致性来找到最佳姿态。在实验中,我们展示了我们的方法能够克服全向图像的严重视觉失真,并且能够充分利用360度相机的宽广视场(FOV)来准确稳定地重建各种场景。代码将在https://github.com/liubonan123/OmniColor/发布。

主要贡献

本文描述了一种优化独立360度相机生成的彩色图像与相应几何重建之间映射的方法,该方法通过一个统一的优化框架来解决存在的问题,其中我们共同优化所有彩色帧的姿态,以校正不准确的着色区域。所有图像的相机姿态都是全局优化的,以最大化一个统一的目标:着色点云地图的光度一致性。此外,该方法非常适合360度相机。它使我们能够在优化过程中绕过相机和点云之间的可见性关系的不可微分变化,显著降低了计算成本。总的来说,我们的贡献可以总结如下:

- 提出了一种新颖的LiDAR-360相机融合的全局优化方法,用于方便而精确的点云着色,能够克服全向图像中的严重视觉失真,并从更宽广的视场中获益。

- 提出了一种新颖的点云共视性估计方法,可以减轻点云表面上的噪声对可见性关系的影响。

- 我们的方法操作简便,可以与任何移动地图系统无缝集成,同时确保方便性和准确性,大量实验证明了它相对于现有框架的优越性。

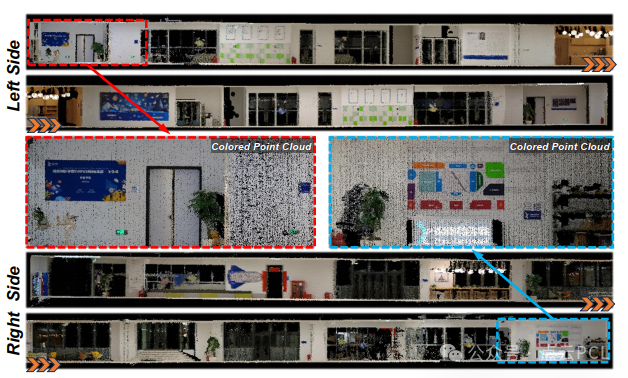

图1. 我们的移动地图系统重建的RGB彩色点云,点云左侧和右侧的大有提升的渲染图像。

内容概述

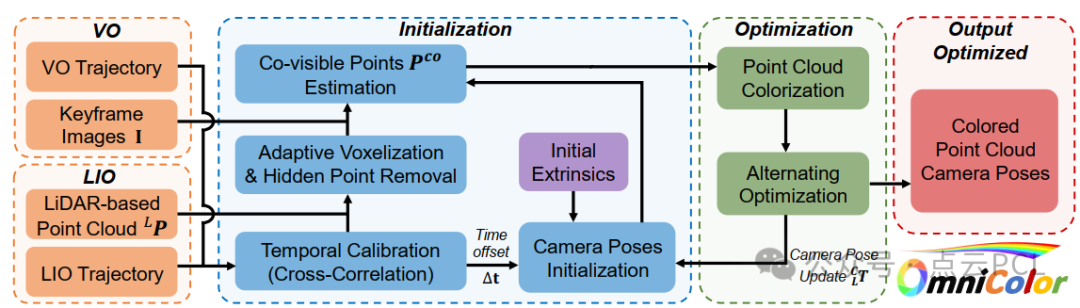

图2. 本文提出的系统概览

图2展示了我们提出的方法论的概述,其中输入来自两个已经建立的强大系统:LiDAR-惯性里程计(LIO)系统和视觉里程计(VO)系统。通过采用基于LIO的方法,可以获取高精度的LiDAR位姿和足够校正的点云地图,利用高频IMU数据生成平滑且精确的运动轨迹。此外,作为预处理步骤,还可以选择性地使用[24],[25],[26]来提高点云结果的质量。将最终的全局点云输入表示为LP。同时还实现了一个VO系统来通过比较它们的运动信号通过交叉相关来估计LiDAR和相机系统之间的时间偏移Δt。

鉴于移动地图设备的手持性质,运动模糊显着影响了输入彩色图像的质量,为了增强计算出的彩色点云,我们的方法自主选择一组输入图像,利用VO系统生成的一系列关键帧作为选择的基础。然后,我们使用无参考度量评估和量化每个关键帧图像的模糊程度。随后在选择最后的关键帧之后,在每个时间段(t−,t+)中添加模糊度最低的帧。选择的图像集合表示为I = {I1, ...In}。根据初始外参参数、时间校准结果和设备轨迹,计算出粗略的关键帧姿态。

初始化

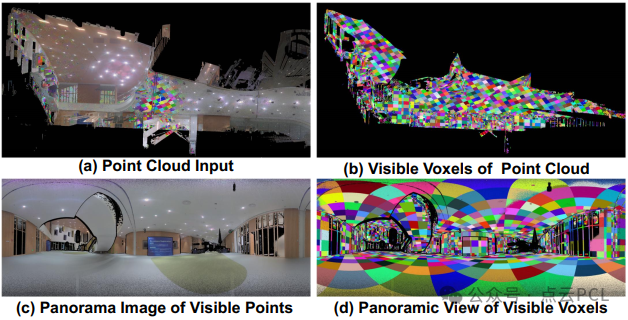

隐藏点剔除中的自适应体素化:该模块的主要目标是从给定的视点识别点云的可见部分,此操作涉及两个关键步骤:点变换和凸包构造。然而,现有的3D凸包算法不适用于GPU的并行计算模型,这使它们不适合处理大规模的点云。为了解决这一挑战,我们利用体素地图中的根节点预定义了最大搜索距离,而叶节点则作为点云的表示,这种优化显著加快了凸包的计算速度。然而必须承认,使用固定分辨率的体素地图会在分割时间和准确性之间进行权衡。为了更好地适应环境,我们将自适应体素化方法集成到我们的工作流程中,以进一步加快处理速度。

图3. 隐藏点剔除中的自适应体素化,输入点云使用自适应体素化的数据结构进行组织,以加快处理速度,经过自适应体素化后,每个体素代表一个平坦表面,保持了一致的可见关系。

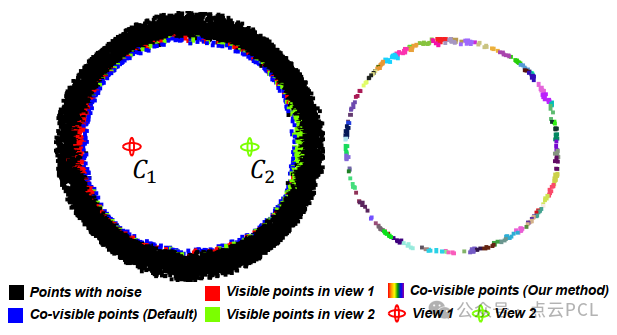

点云共视性估计:首先概述了建立点云共视性估计方法的流程,旨在减少点云表面噪声对可见性关系的影响。为了实现这一目标,我们首先将全局点云细分为多个体素,并评估每个点的可见性,以确定每个关键帧Ii的可见区域,基于相机视图。这个操作在图3 (a-d)中进行了说明。可见点云集合表示为PV = P1, .., Pn ,其中Pi表示关键帧Ii的可见点集,idxi表示点pi所属的体素节点的索引,m是可见点的计数。接下来,我们基于点云的共视性构建一个共视性图。如果共享相同体素索引的两个关键帧中可见点的计数超过了预定义的阈值(例如,这些关键帧中可见点的最小计数的一半),则在它们之间建立一条边。共视点被添加到每个关键帧的可见点集中,表示为Pi → Pi+,其中Pi+表示每个关键帧的更新后的可见点集,共视点集合表示为Pco。如图4所示,我们提供了在2D空间中上述方法的结果示例,提供了我们方法和默认交集方法之间的定量比较。

图4. 在2D圆形模拟点云数据上展示点云共视性估计

相机位姿优化

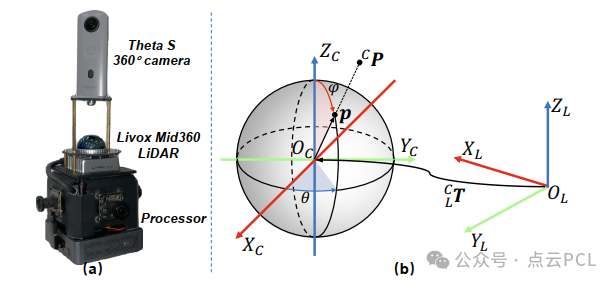

损失函数:这里引入了一个损失函数,该函数在点云中的共视点的投影位置评估每个关键帧的像素值与真实颜色之间的差异。通过优化相机姿态和辅助变量集合,我们可以最小化投影像素值与真实颜色之间的差异,从而实现颜色映射的精确性。此外利用基于点云的采样损失来实现全局优化,以显著降低计算成本,并在处理360度相机时实现稳定的结果。图5展示了LiDAR点云和相机坐标系。

图5. (a) 移动地图系统和 (b) LiDAR-相机坐标系统

交替优化:本文实现了一种交替优化方案,以最小化损失函数。基本思想是在CLT和C之间交替优化。当优化C时,保持CLT 固定,反之亦然。在固定C LT 时初始化相机姿态时,我们使用相机和LiDAR里程计之间的外参标定。然后根据初始粗略的相机姿态和关键帧图像对点云进行着色。然而由于点云地图中的轻微不准确性、来自不同相机视角的光照变化以及粗略的相机姿态,着色误差是不可避免的。为了减轻这个问题,我们使用了一种鲁棒的平均形式。点云中的每个点都有一组候选颜色,候选颜色的数量表示为k。然后,非线性问题方程被转化为一个具有闭式解的线性最小二乘问题。

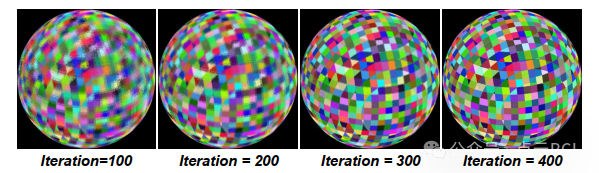

OmniColor的核心部分是对采样损失进行简单的梯度下降,这在计算上是高效的。同时损失函数可以有效处理对360度图像的全面分析,并展现出对视觉失真的稳健性。图6展示了我们在模拟数据集上的损失函数优化过程的示例。

图6. 优化过程中的着色结果,我们的方法能够处理球形模拟点云,这些点云本身缺乏明显的几何特征。

实验

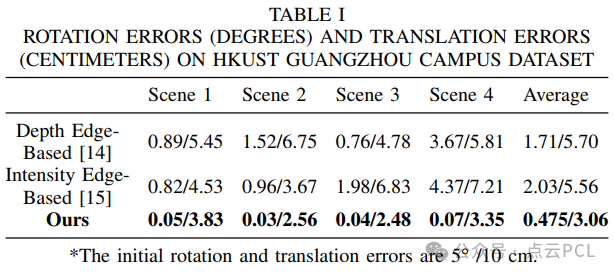

为了评估所提方法的性能,我们将其与其他最先进的方法进行比较,使用两类数据集。第一类包括从移动地图设备收集的数据,具体来说是Livox Mid360固态LiDAR用于高分辨率点云测量,以及RICOH Theta S 360度摄像机用于定性分析(见图7),第二类包括从位于香港科技大学广州校区内的名为BKL360的静止LiDAR扫描仪捕获的数据,其中包括从各种位置和方向拍摄的超过10个站点帧的四个场景。此外,我们利用公开可用的Omniscenes数据集,其中包括具有地面真值相机姿态和场景3D点云的全景图像序列,以与基于SfM的方法[32]进行比较。最后,采用模拟数据集进行关于点云共视估计的消融研究。为了在旋转误差(单位:度)和平移误差(单位:厘米)方面定量比较我们优化后的参数与地面真值的差异,我们在运行优化算法之前向原始摄像机视图添加了随机旋转和平移噪声。初始旋转和平移误差计算为5.0◦/10cm。实验结果的展示旨在通过定量和定性分析直接展示我们方法的有效性。

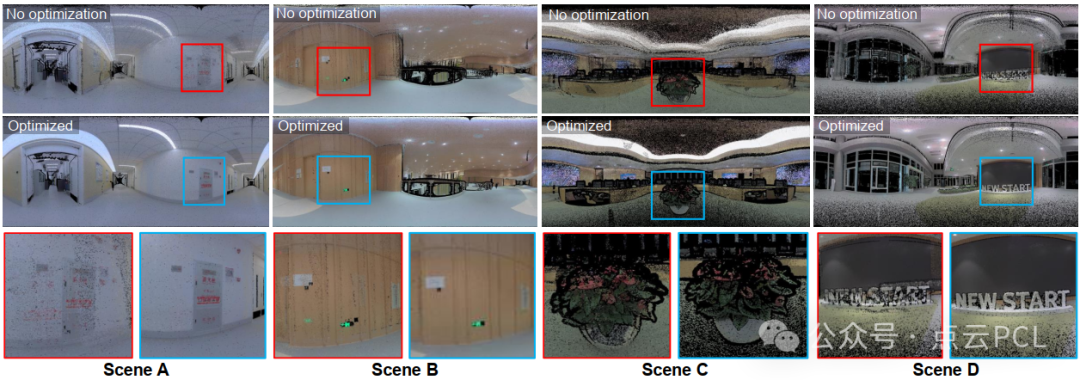

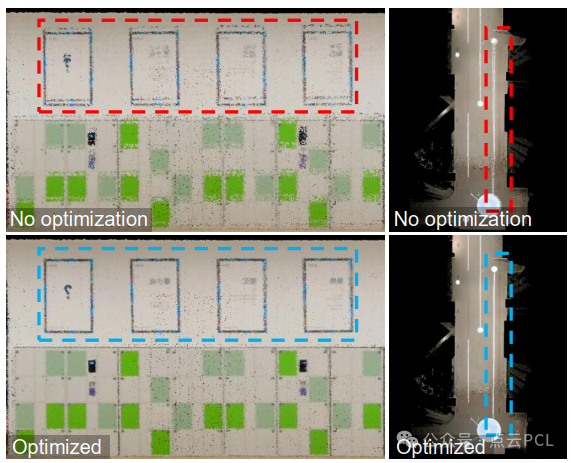

图7. 香港科技大学广州校区数据集(场景A-D)的彩色化结果的渲染图像。左图(红色):优化前带噪声的彩色点云。右图(蓝色):经我们方法优化的彩色点云。

定量结果

本文的方法专门针对利用360度相机,为了与其他方法进行比较,我们将全景图像矫正成一个视场角为160度的针孔图像,并将输入点云分割成以粗略相机视图为中心的多个局部地图。具体来说将我们的方法与两种基于边缘特征的外参校准方法进行比较:点云中的深度连续边缘和从LiDAR强度图像中提取的边缘特征,这些方法通过外参校准将局部地图与彩色图像对齐。我们通过作者的努力来微调每种方法的参数,以达到最佳性能。对于每种方法,在所有场景中采用一致的参数设置。

实验结果总结如表I所示。我们的方法在香港科技大学广州校区数据集的所有场景中的准确性方面优于其他方法。与基于边缘特征的方法相比,这种方法对环境的敏感性更强,在几个局部地图中遇到失败,我们的方法表现出处理各种地图场景的鲁棒性。

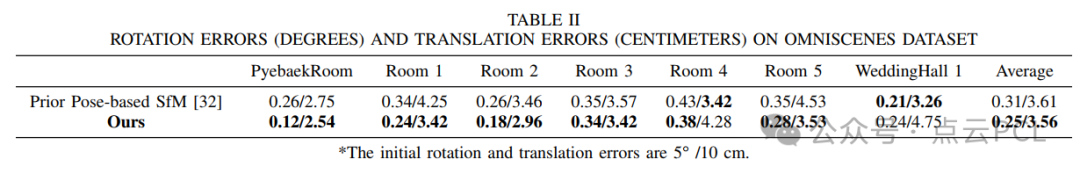

为了进行公平比较,我们将全景图像转换为六个立方体针孔图像,并通过随机扰动地面真值(旋转5.0°,平移10cm)来初始化粗略的相机姿态。在优化处理中,我们对从同一全景图像派生的六个立方体针孔图像添加了刚性约束。结果如表II所示。我们注意到,我们方法的准确性接近于联合SfM方法,尽管达到了近似的准确性,但我们的方法是一种直接方法,不需要任何特征提取和匹配过程,可以显著降低计算成本。此外,我们的优化方案使得利用现代GPU的能力并行更新所有姿态和点云着色结果变得容易。

定性结果

除了定量比较外,我们特意选择了香港科技大学广州校区数据集中来自不同序列的基于特征的方法的各种失败场景。这些场景突出显示了我们的方法在所有场景中能够实现一致高质量的结果。图7展示了我们的方法如何显著增强了点云着色的结果。在移动地图数据集的情况下,如图8所示。结果清楚地表明了我们的方法在着色方面取得的显著改善。

图8. 我们移动地图设备重建的着色点云。顶部:基于插值相机姿态的着色。底部:基于优化相机姿态的着色。

关于点云共视估计的消融研究

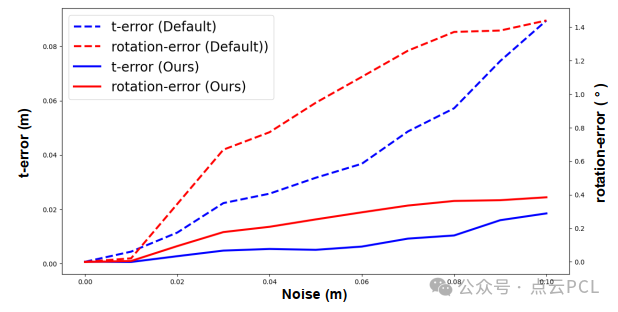

使用一个由我们生成的模拟数据集进行了这个实验,该数据集由半径为10米的球内的点组成。图6展示了我们在优化过程中着色过程的进展。在这一部分中,我们进行定量分析以评估点噪声对优化结果的影响。图9展示了噪声范围从1厘米到10厘米的情况。结果表明,我们的方法有效地减轻了点云表面的噪声影响,从而导致更精确的相机姿态。

图9. 关于相机姿态优化的点共视估计方法的消融研究

总结

本文提出了一种新颖而高效的算法(OmniColor),利用独立的360度相机对点云进行着色,它利用相机的全方位感知视角,并消除了严重的球形失真影响,同时保持了计算效率。在我们的专有数据集和公开数据集上进行的实验中,与现有算法相比,OmniColor在准确性和稳定性方面表现出色。此外,OmniColor可以与任何移动地图系统无缝集成,在虚拟现实和机器人等各个领域的应用中具有广阔的可能性,其中对清晰和精确的着色点云地图的需求至关重要。