Python基础教程(二十七):urllib模块

在Python中,urllib模块是一组用于处理URLs的标准库,它提供了发送网络请求、解析URLs、处理重定向和错误等功能。对于进行Web爬虫开发、数据抓取和API调用等任务,urllib模块是非常实用的工具。本文将深入探讨urllib模块的各个组成部分,包括urllib.request, urllib.parse和urllib.error,并通过具体案例帮助你掌握如何使用这些模块进行网络请求和数据处理。

【测试开发】python系列教程:urllib

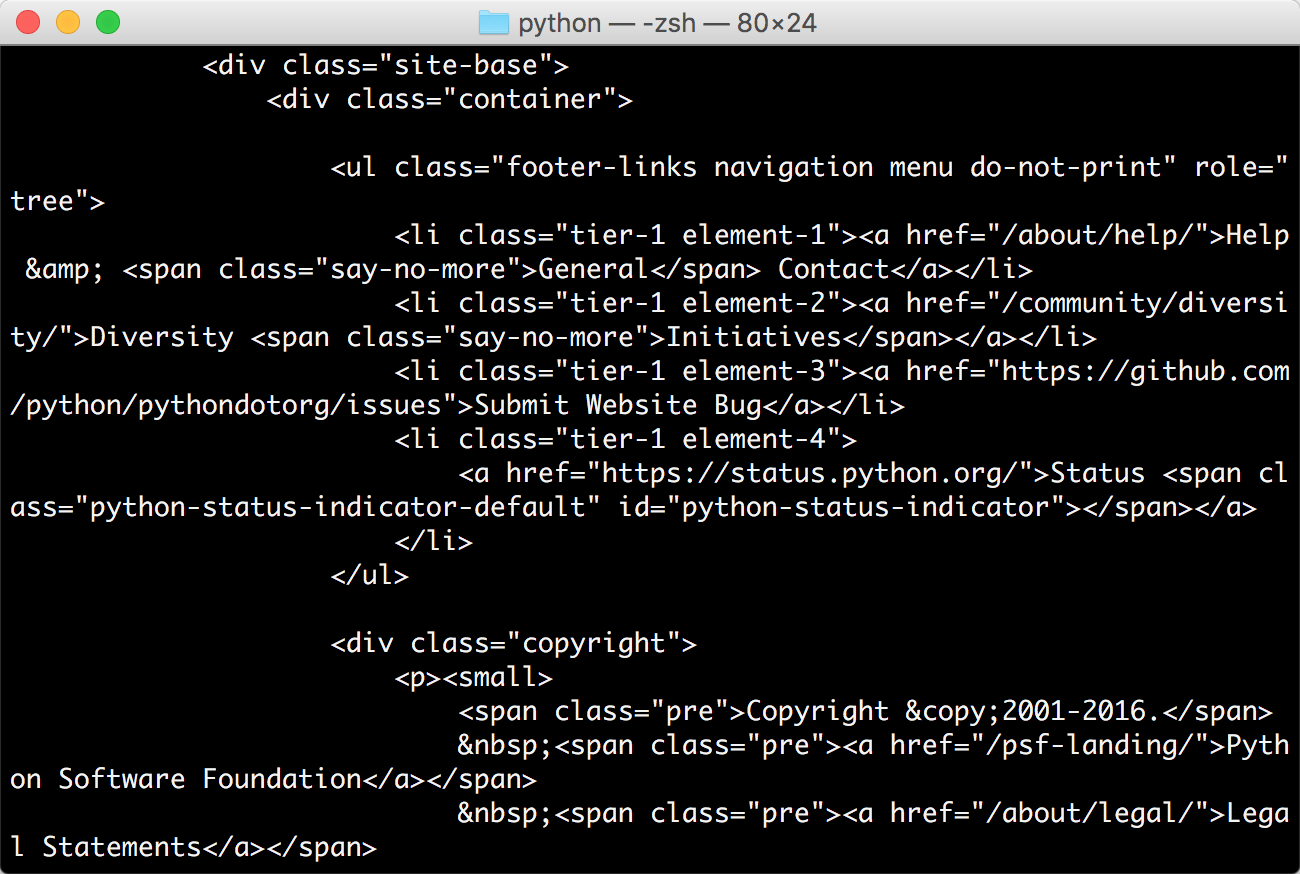

大家都熟知的爬虫,爬虫就是请求网页,进行网页的抓取,那么如何进行网页的抓取呢,今天呢,给大家分享一个能够请求网页,进行数据抓取的库,python自带的urllib。

python爬虫实例(urllib&Be

list_card=['……','……']#list of card string

Python爬虫urllib详解

学习爬虫,最初的操作便是模拟浏览器向服务器发出请求,那么我们需要从哪个地方做起呢?请求需要我们自己来构造吗?需要关心请求这个数据结构的实现吗?需要了解 HTTP、TCP、IP 层的网络传输通信吗?需要知道服务器的响应和应答原理吗?

Python爬虫技术系列-01请求响应获取-urllib库

参考连接:

https://zhuanlan.zhihu.com/p/412408291

python脚本检查网页能否打开

转

(adsbygoogle = window.adsbygoogle || []).push({});

练手爬虫用urllib模块获取

练手爬虫用urllib模块获取

有个人看一段python2的代码有很多错误

import re

import urllib

def getHtml(url):

page = urllib.u

如何使用python+urllib库+代理IP访问网站

python 写爬虫获取数据资料是方便的,但是很多网站设置了反爬虫机制,最常见的就是限制 IP 频繁请求了,只要某个 IP 在单位时间内的请求次数超过一定值,网站就不再正常响应了,这时,我们的 python 爬虫就无法正常工作了。对于这种情况最简单的方式就是使用代理(proxy)。但是使用还是会出现一些问题,比如下面的例子

Python爬虫urllib详解

学习爬虫,最初的操作便是模拟浏览器向服务器发出请求,那么我们需要从哪个地方做起呢?请求需要我们自己来构造吗?需要关心请求这个数据结构的实现吗?需要了解 HTTP、TCP、IP 层的网络传输通信吗?需要知道服务器的响应和应答原理吗?

【测试开发】python系列教程:urllib

大家都熟知的爬虫,爬虫就是请求网页,进行网页的抓取,那么如何进行网页的抓取呢,今天呢,给大家分享一个能够请求网页,进行数据抓取的库,python自带的urllib。