作业帮的云原生历程与实践

本文源自作业帮基础架构负责人董晓聪的分享。讲述作业帮的云原生历程,并围绕云原生架构和多云架构两大解决方案进行深入延展。

云原生改造重塑技术体系

“之前在传统的互联网公司,大家没法接触到用户,对用户的感知更多的是一个个 UV、PV 数字,但在线教育不一样,我们通过直播等形式面对的是一个个学生,每一次稳定性的事故都可能会影响他们的学业,所以作业帮对稳定性的要求只能更高。”据董晓聪介绍,作业帮在稳定性层面,主要面对以下三大挑战:

当出现单机、单机群、单云故障的时候,架构能否很好的应对这些冲击?

当代码变更导致业务

作业帮的云原生历程与实践

本文源自作业帮基础架构负责人董晓聪的分享。讲述作业帮的云原生历程,并围绕云原生架构和多云架构两大解决方案进行深入延展。

云原生改造重塑技术体系

“之前在传统的互联网公司,大家没法接触到用户,对用户的感知更多的是一个个 UV、PV 数字,但在线教育不一样,我们通过直播等形式面对的是一个个学生,每一次稳定性的事故都可能会影响他们的学业,所以作业帮对稳定性的要求只能更高。”据董晓聪介绍,作业帮在稳定性层面,主要面对以下三大挑战:

当出现单机、单机群、单云故障的时候,架构能否很好的应对这些冲击?

当代码变更导致业务

函数计算WordPress实例预热程序

函数计算有冷启动的问题,如果启用VPC,还有VPC的启动时间,为了避免冷启动问题,可以通过预热程序来避免函数实例被销毁。此预热程序示例使用Cloudflare Worker,正好同时用预热程序支持Wordpress的定时任务。

函数计算WordPress实例预热程序

函数计算有冷启动的问题,如果启用VPC,还有VPC的启动时间,为了避免冷启动问题,可以通过预热程序来避免函数实例被销毁。此预热程序示例使用Cloudflare Worker,正好同时用预热程序支持Wordpress的定时任务。

必应搜索高清壁纸接口分享

最近听说今日头条开始做全网的搜索了,那现在数一数应该是百度、谷歌、必应、搜狗等几个常见搜索引擎喽!闲来无事看了看必应的搜索网站,做的还是非常棒的,分为了国际版和国内版。

Linux基础 - Crontab定时任务

当然有更简单的方法,你可以在 https://crontab.guru/ 网站进行在线设置,设置好了直接拷贝过来。网页提供了图形化的操作界面,对新手特别友好。

5分钟教你SSL证书自动巡检与过期提醒

我们首先定义了一个checkCertificates函数,该函数的主要任务是读取一个名为domain.txt的文件,该文件中列出了需要检查的域名和对应的IP地址。

Sh备份数据库

sh脚本备份数据库

#!/bin/bash

BACKUP=/u01/backup/MySQL/

DATETIME=$(date '+%Y-%m-%d')

DB_HOST=127.0.0.1

DB_USER=root

DB_PWD=root

DATABASE1=test

DATABASE2=test_api

mkdir -p "${BACKUP}/$DATETIME"

TIME=$(date '+%H%M%S')

mysqldump -u${DB_USER} -p${DB_PWD} -h${DB_HOST}

js中settimeout和setinterval的区别是什么?

javascript的setTimeOut和setInterval函数应用非常广泛,在网站中经常用来处理延时延时和定时任务,比如打开网页一段时间后弹出一个登录框,页面每隔一段时间发送异步请求获取最新数据等等。但它们的应用是有区别的。

【开源推荐】强烈推荐你看看这个PHP定时任务扩展包EasyTak的使用方法

这个包在我们做定时任务或者需要任务调度系统时特别实用,这是一个composer包,你可以把它安装在你需要的地方,下面说一下这个包吧。

宝塔面板一键优化补丁(包含Linux与Win版)

3. 去除创建网站自动创建的垃圾文件(index.html、404.html、.htaccess)

宝塔面板使用www用户执行命令,宝塔定时任务使用www用户执行命令

由于大部分的网站都是以www身份运行的,但是宝塔面板大家一般都是以root身份安装的,在使用定时任务时候会导致很多问题。例如root身份运行定时任务导致网站生成的缓存目录都是root权限,正常通过www访问的请求无法正常读写。于是我修改了定时任务。

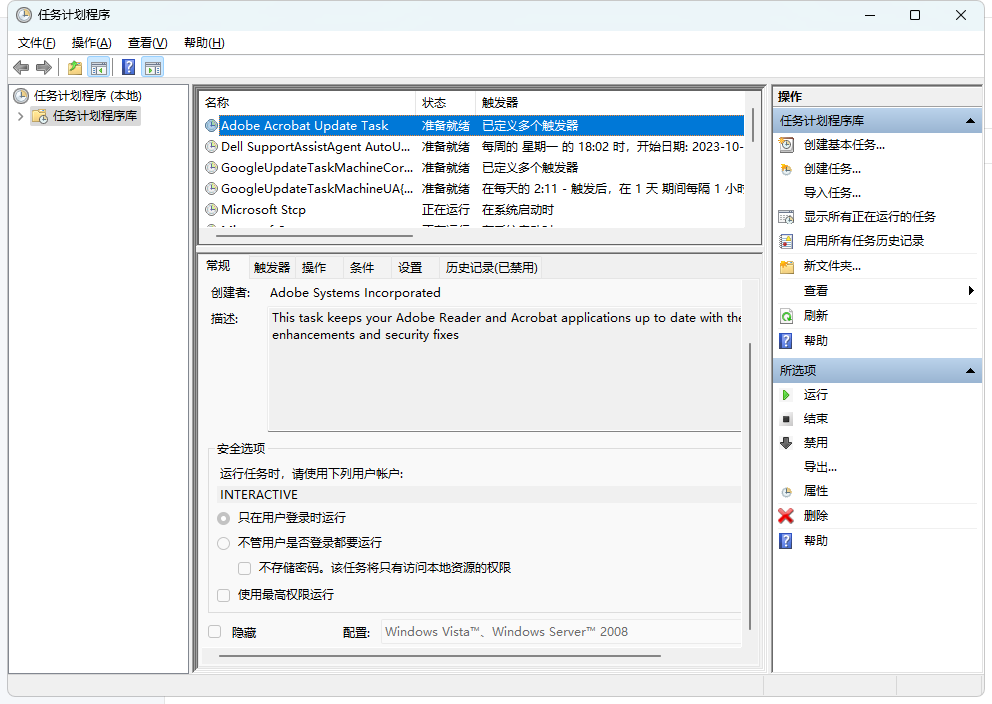

Windows环境下任务计划执行R语言脚本

因日常需要,需要定期关注国家局某些网站的政策动向,不想有事没事就跑网站去看,索性就用R语言脚本写了一段代码获取是否有新的政策文件。

利用Python和Selenium实现定时任务爬虫

定时爬虫是指能够按照预设的时间周期性地执行网络爬取任务的程序。这种类型的爬虫通常用于需要定期更新数据的场景,比如新闻网站、股票信息等。使用定时爬虫可以减轻人工操作的负担,保证数据的及时性和准确性。

利用Python和Selenium实现定时任务爬虫

网络爬虫在信息获取、数据分析等领域发挥着重要作用,而定时爬虫则可以实现定期获取网站数据的功能,为用户提供持续更新的信息。在Python中,结合Selenium技术可以实现定时爬虫的功能,但如何设置和优化定时爬虫的执行时间是一个关键问题。本文将介绍如何在Python中设置和优化Selenium定时爬虫的执行时间,以及一些优化策略和注意事项。

简单实用node脚本:通过定时任务和2个fetch请求实现网站自动签到功能

有一个网站每天签到可以获取流量,之前每天都是自己打开网页登录然后手动点签到,但是如果连续7天没签到之前获取的所有流量都会清空。类似的需求会有很多,很多网站、应用也都会提供签到获取积分、金币、能量、饲料...其实用node脚本来实现每天自动签到很简单。

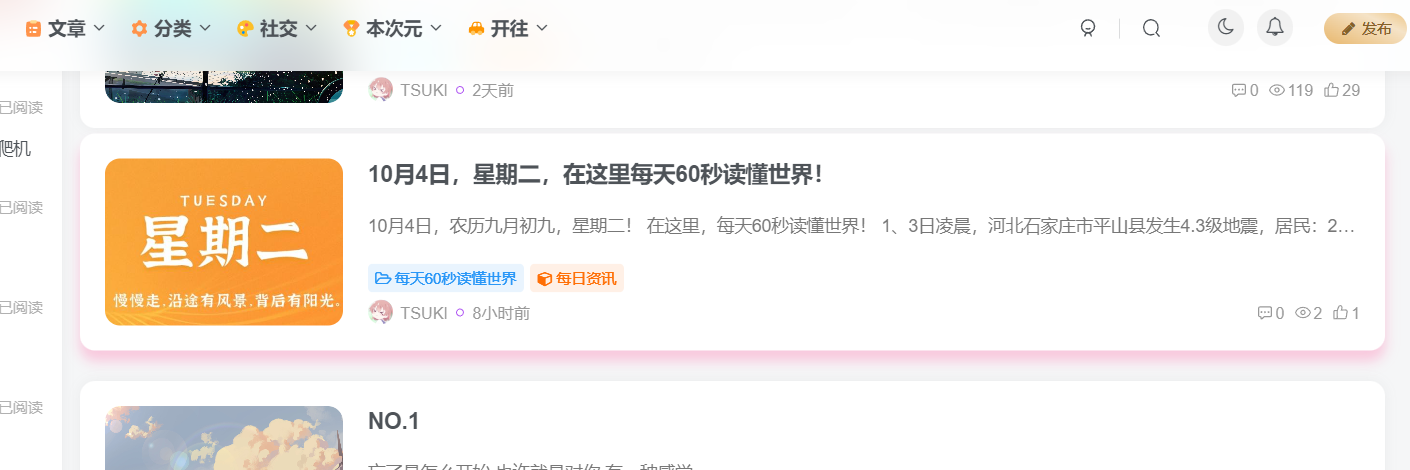

给网站加一个定时发布《每天60s读懂世界》功能

效果预览源代码代码语言:javascript复制<?php

$date = file_get_contents("https://www.zhihu.com/api/v4/columns/c_1261258401923026944/items");

$date = json_decode($date);

$content = $date->data[0]->content;

$pattern ='<img.*?src="(.*?)">';

preg_match($pattern,$content,$matc...

bye 我的博客网站

Bye🙋🙋🙋,我的博客网站。在我的服务器上运行了9个月之久的博客网站要和大家Bye了。

Spring boot定时任务

可以看出@Scheduled(fixedDelay = 3000)表示执行完第一次后延迟3000毫秒再次执行

5分钟教你SSL证书自动巡检与过期提醒

我们首先定义了一个checkCertificates函数,该函数的主要任务是读取一个名为domain.txt的文件,该文件中列出了需要检查的域名和对应的IP地址。