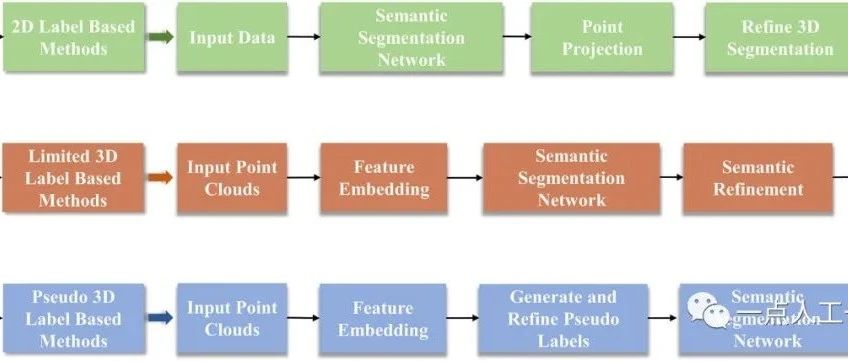

弱监督三维点云语义分割研究综述

作者:Jingyi Wang, Yu Liu, Hanlin Tan, Maojun Zhang

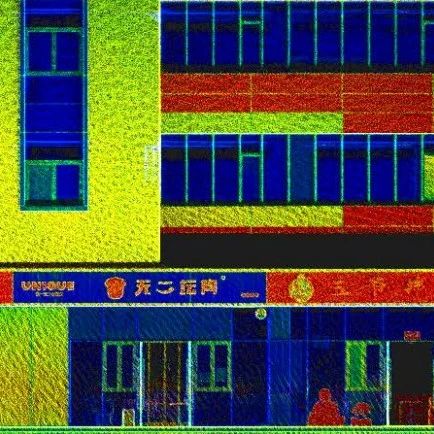

【前沿】基于SLAM点云数据的BIM模型重建

建筑信息化是当今各个行业、各个领域发展的趋势,建筑信息模型等空间信息化建设技术已经成为社会发展不可或缺的一部分,它最突出的特点便是能够运用信息技术创建出贴合实际的数字化模型,从信息角度、三位视角对建筑的生命全周期进行反映、控制和管理。在以往的建筑保护管理工作中,以计算机辅助设计技术取代手工绘图被称为建筑文化发展的第一次数字革命。现在,作为一项新兴技术的三维可视化技术足以引发建筑文化发展的第二次技术革命,在这种大背景下,如何利用新兴技术服务与建筑的保护、管理、修复等工作,已经成为广大从业者必须要考虑和学习的问题。

SCRM项目技术实现:构建卓越的客户关系管理平台

随着互联网技术的不断发展,企业与客户之间的关系管理变得愈发重要。为了提升企业的销售和服务能力,SCRM(Social Customer Relationship Management)项目的技术实现成为了一个热门话题。本文将详细介绍SCRM项目的技术实现,包括数据采集、智能分析、个性化推荐等方面,以帮助科技博主和读者们了解如何构建卓越的客户关系管理平台。

SCRM项目技术实现:构建卓越的客户关系管理平台

随着互联网技术的不断发展,企业与客户之间的关系管理变得愈发重要。为了提升企业的销售和服务能力,SCRM(Social Customer Relationship Management)项目的技术实现成为了一个热门话题。本文将详细介绍SCRM项目的技术实现,包括数据采集、智能分析、个性化推荐等方面,以帮助科技博主和读者们了解如何构建卓越的客户关系管理平台。

踏入网页抓取的旅程:使用 grequests 构建 Go 视频下载器

在当今数字化的世界中,网页抓取技术变得越来越重要。无论是获取数据、分析信息,还是构建自定义应用程序,我们都需要从互联网上抓取数据。本文将介绍如何使用 Go 编程语言和 grequests 库来构建一个简单的 Bilibili 视频下载器,同时利用爬虫代理 IP 技术来提高稳定性和速度。

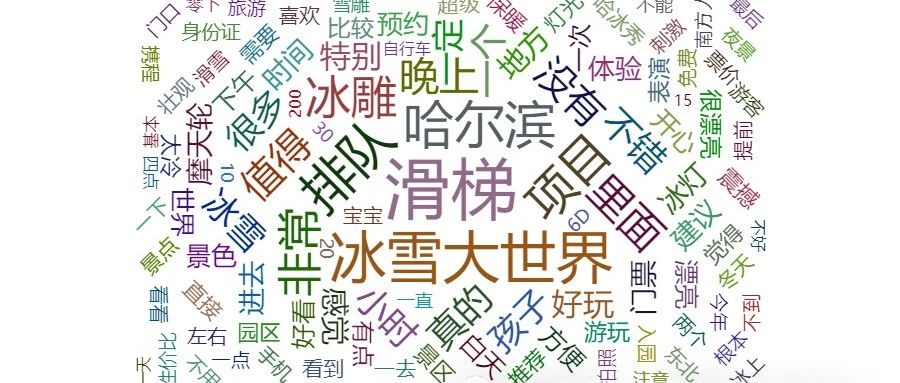

【数据分析实战】冰雪大世界携程景区评价信息情感分析采集词云

今年冬天,哈尔滨冰雪旅游"杀疯了",在元旦假期更是被南方游客"包场"。据哈尔滨市文化广电和旅游局提供大数据测算,截至元旦假日第3天,哈尔滨市累计接待游客304.79万人次,实现旅游总收入59.14亿元。游客接待量与旅游总收入达到历史峰值。

Puppeteer动态代理实战:提升数据抓取效率

Puppeteer是由Google Chrome团队开发的一个Node.js库,用于控制Chrome或Chromium浏览器。它提供了高级API,可以进行网页自动化操作,包括导航、屏幕截图、生成PDF、捕获网络活动等。在本文中,我们将重点介绍如何使用Puppeteer实现动态代理,以提高数据抓取效率。

如何使用WebBits和Haskell采集人人网

大家好,前面给大家分享了关于采集人人网的相关代码的示例,今天给大家带来的也是一个采集人人网的爬虫实例,是通过WebBits和Haskell相结合,比较简洁,也非常易懂,让我们一起来学习一下。

如何使用PyQuery库制作一个精美的头条采集程序

我们都知道,今日头条资源丰富,又其实是平台上有许多精美的图片,可以利用进行学习。那么今天呢,我就给大家分享的是用PyQuery库编写的今日头条中的图片采集程序,代码不长,但是非常实用,一起来学习学习吧。

如何利用Haskell结合WebBits库采集淘宝图片

在电商行业中,我们经常需要对同行的产品进行分析对比,今天我就给大家分享一个Haskell函数结合WebBits库编写的采集淘宝图片的例子,非常的简单实用,一起来学习一下吧。

使用phpQuery库采集平安健康代码示例

大家好,今天给大家分享的内容是使用phpQuery库采集平安健康相关视频,内容非常简单,篇幅也很短,但是确实很实用,一起学习一下吧。

提升爬虫OCR识别率:解决嘈杂验证码问题

在数据抓取和网络爬虫技术中,验证码是常见的防爬措施,特别是嘈杂文本验证码。处理嘈杂验证码是一个复杂的问题,因为这些验证码故意设计成难以自动识别。本文将介绍如何使用OCR技术提高爬虫识别嘈杂验证码的准确率,并结合实际代码示例,展示如何使用爬虫代理IP技术来规避反爬措施。

PHP编程实践:实际商品价格数据采集

在电子商务领域,对商品价格进行数据采集和对比是一项常见的需求。本文将介绍如何使用PHP编程语言实现对1688和淘宝商品价格数据的采集和对比,帮助读者了解实际的编程实践过程。

高效爬取Reddit:C#与RestSharp的完美结合

在数据驱动的时代,网络爬虫已经成为获取网页数据的重要工具。Reddit,作为全球最大的社区平台之一,以其丰富的用户生成内容、广泛的讨论话题和实时的信息更新吸引了大量用户。对于研究人员和开发者而言,Reddit提供了宝贵的数据源,可用于文本分析、舆情监控和趋势研究等多个领域。

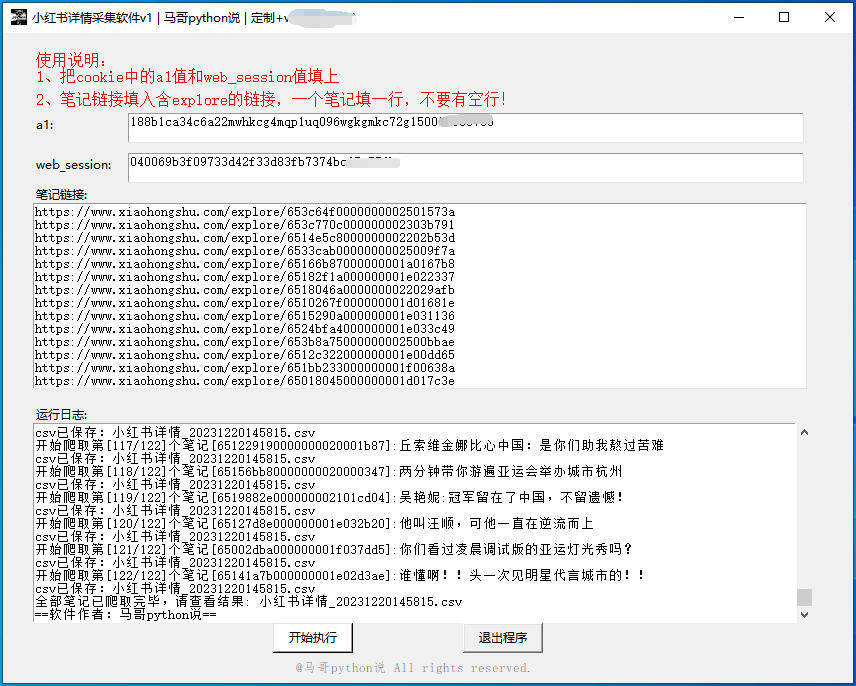

爆款小红书笔记采集神器!Python开发,正文一键爬取

小红书是国内集社交、分享、购物于一体的综合性平台,为用户提供了一个交流经验、获取灵感和享受购物乐趣的沟通渠道,同时也是国内流量数一数二的生态网站。很多行业的操盘手需要获取热门笔记、热门作者的作品数据,从而提升自己账号的互动数据和价值。因此,我用python开发了一个爬虫采集软件,可自动按笔记链接抓取笔记的详情数据。

数据采集-Scrapy框架使用代理IP要点

scrapy框架通过模块化的设计实现了数据采集的通用功能接口,并提供自定义拓展,它将程序员从繁冗的流程式重复劳动中解放出来,给编程人员提供了灵活简便的基础构建,对于普通的网页数据采集,编程人员只需要将主要精力投入在网站数据分析和网站反爬策略分析上,结合代理IP的使用,可以实现项目的高效快速启动。

主要特性包括:

1)参数化设置请求并发数,自动异步执行

2)支持xpath,简洁高效

3)支持自定义中间件middleware

4)支持采集源列表

5)支持独立调试,方便 shell 方式

6)支持数据管道接口定义,用户可以选择文本、数据库等多种方式

在Scrapy框架中使用代理的方式有如下几种:

1.scrapy中间件

在项目中新建middlewares.py文件(./项目名/middlewares.py),内容如下:

#! -- encoding:utf-8 --

import base64

import sys

import random

PY3 = sys.version_info[0] >= 3

def base64ify(bytes_or_str):

if PY3 and isinstance(bytes_or_str, str):

input_bytes = bytes_or_str.encode(‘utf8’)

else:

input_bytes = bytes_or_str

output_bytes = base64.urlsafe_b64encode(input_bytes)

if PY3:

return output_bytes.decode(‘ascii’)

else:

return output_bytes

class ProxyMiddleware(object):

def process_request(self, request, spider):

# 代理服务器(产品官网 www.16yun.cn)

proxyHost = “t.16yun.cn”

proxyPort = “31111”

# 代理验证信息

proxyUser = “username”

proxyPass = “password”

request.meta[‘proxy’] = “http://{0}:{1}”.format(proxyHost,proxyPort)

# 添加验证头

encoded_user_pass = base64ify(proxyUser + “:” + proxyPass)

request.headers[‘Proxy-Authorization’] = 'Basic ’ + encoded_user_pass

# 设置IP切换头(根据需求)

tunnel = random.randint(1,10000)

request.headers[‘Proxy-Tunnel’] = str(tunnel)

修改项目配置文件 (./项目名/settings.py)

DOWNLOADER_MIDDLEWARES = {

‘项目名.middlewares.ProxyMiddleware’: 100,

}

2.scrapy环境变量

通过设置环境变量,来使用爬虫代理(Windows)

C:>set http_proxy=http://username:password@ip:port

数据采集-Scrapy框架使用代理IP要点

scrapy框架通过模块化的设计实现了数据采集的通用功能接口,并提供自定义拓展,它将程序员从繁冗的流程式重复劳动中解放出来,给编程人员提供了灵活简便的基础构建,对于普通的网页数据采集,编程人员只需要将主要精力投入在网站数据分析和网站反爬策略分析上,结合代理IP的使用,可以实现项目的高效快速启动。

主要特性包括:

1)参数化设置请求并发数,自动异步执行

2)支持xpath,简洁高效

3)支持自定义中间件middleware

4)支持采集源列表

5)支持独立调试,方便 shell 方式

6)支持数据管道接口定义,用户可以选择文本、数据库等多种方式

在Scrapy框架中使用代理的方式有如下几种:

1.scrapy中间件

在项目中新建middlewares.py文件(./项目名/middlewares.py),内容如下:

#! -- encoding:utf-8 --

import base64

import sys

import random

PY3 = sys.version_info[0] >= 3

def base64ify(bytes_or_str):

if PY3 and isinstance(bytes_or_str, str):

input_bytes = bytes_or_str.encode(‘utf8’)

else:

input_bytes = bytes_or_str

output_bytes = base64.urlsafe_b64encode(input_bytes)

if PY3:

return output_bytes.decode(‘ascii’)

else:

return output_bytes

class ProxyMiddleware(object):

def process_request(self, request, spider):

# 代理服务器(产品官网 www.16yun.cn)

proxyHost = “t.16yun.cn”

proxyPort = “31111”

# 代理验证信息

proxyUser = “username”

proxyPass = “password”

request.meta[‘proxy’] = “http://{0}:{1}”.format(proxyHost,proxyPort)

# 添加验证头

encoded_user_pass = base64ify(proxyUser + “:” + proxyPass)

request.headers[‘Proxy-Authorization’] = 'Basic ’ + encoded_user_pass

# 设置IP切换头(根据需求)

tunnel = random.randint(1,10000)

request.headers[‘Proxy-Tunnel’] = str(tunnel)

修改项目配置文件 (./项目名/settings.py)

DOWNLOADER_MIDDLEWARES = {

‘项目名.middlewares.ProxyMiddleware’: 100,

}

2.scrapy环境变量

通过设置环境变量,来使用爬虫代理(Windows)

C:>set http_proxy=http://username:password@ip:port

Go每日一库之178:chromedp(一个基于Chrome DevTools协议的库,支持数据采集、截取网页长图)

该库提供了一种简单、高效、可靠的方式来控制Chrome浏览器进行自动化测试和爬取数据。

「Go开源包」chromedp:一个基于Chrome DevTools协议的库,支持数据采集、截取网页长图

今天给大家推荐一个基于Chrome DevTools协议的Go语言库:chromedp。

拓客必备神器:采集工具让你的数据采集更快更准

企业拓客是指企业通过各种手段,寻找并获取新客户的过程。对于企业来说,拓客是非常重要的一环,可以帮助企业扩大市场份额、提高销售额、增加利润等。但是,拓客过程中存在着一些难点和挑战,例如如何精准定位目标客户、如何获取有效的联系方式等。在这个过程中,关键词采集工具可以发挥重要的作用。